DragAnything – 快手联合浙大等机构开源的可控视频生成方法

2025-03-18 17:13:57 小编:六六导航站

DragAnything是什么

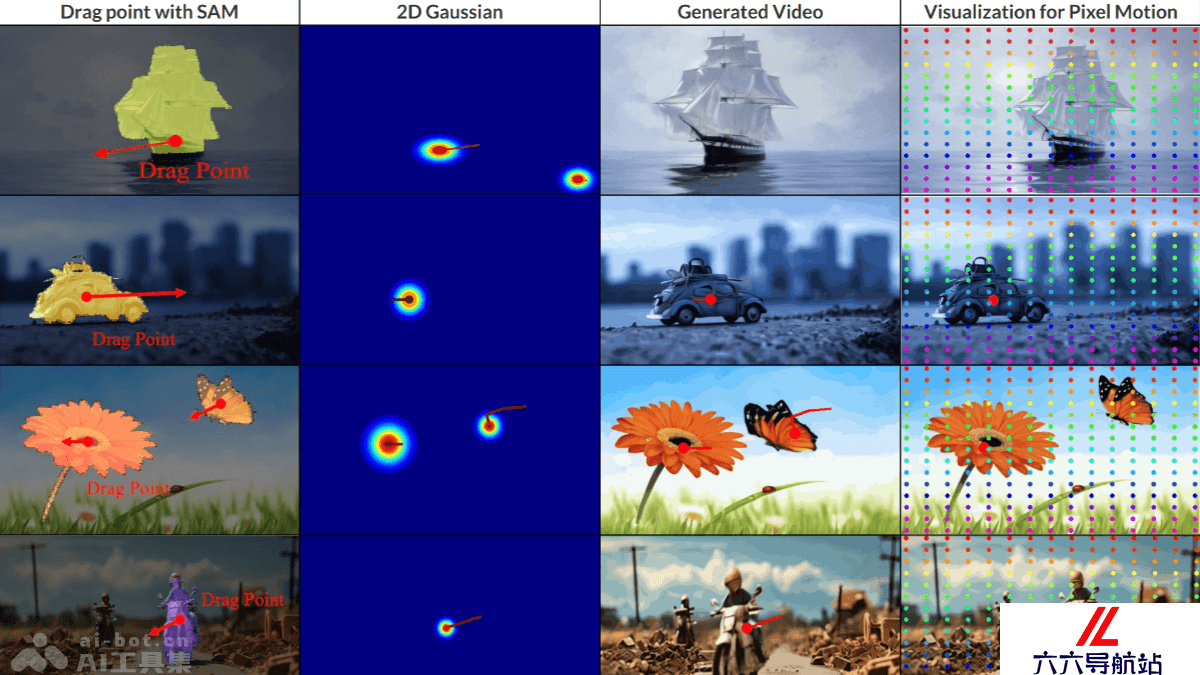

DragAnything 是快手联合浙江大学和新加坡国立大学 Show Lab推出的,基于实体表示的可控视频生成方法,基于简单的轨迹输入实现对视频中任意物体的精确运动控制。DragAnything用扩散模型的潜在特征表示视频中的每个实体,克服传统方法中单纯拖动像素点无法精确控制物体运动的局限性。DragAnything 提供用户友好的交互方式,支持前景、背景及相机运动的灵活控制,在 FID、FVD 和用户研究等评估指标上达到新的最佳性能。

DragAnything的主要功能

实体级运动控制:对视频中的任何实体(包括前景和背景)进行精确的运动控制,不仅是像素级别的操作。多实体独立控制:支持同时对多个物体进行独立的运动控制,每个物体根据用户定义的轨迹进行不同的运动。用户友好的交互方式:用户基于简单的交互(如选择区域并拖动)实现复杂的运动控制,无需复杂的输入信号(如分割掩码或深度图)。相机运动控制:除控制视频中的物体,DragAnything 能实现相机的运动控制,如缩放和平移。高质量视频生成:在保持运动控制精度的同时,生成高质量的视频内容,适用于多种应用场景。DragAnything的技术原理

实体表示:推出新的实体表示方法,从扩散模型的潜在特征中提取语义信息表征视频中的每个物体。将物体的语义特征与运动轨迹相结合,实现精确的实体级运动控制。2D 高斯表示:引入 2D 高斯表示,基于高斯分布对物体的中心区域赋予更高的权重,减少边缘像素的影响,实现更自然的运动控制。扩散模型:基于扩散模型架构(如 Stable Video Diffusion),用强大的生成能力和去噪能力生成高质量的视频内容。扩散模型基于逐步去除噪声重建视频帧,结合用户输入的运动轨迹和实体表示。轨迹引导的运动控制:用户基于绘制简单的轨迹定义物体的运动路径,DragAnything 将轨迹与实体表示相结合,生成符合用户意图的视频内容,避免直接操作像素点的局限性,实现更自然和精确的运动控制。损失函数与优化:在训练阶段,用带有掩码的均方误差(MSE)损失函数,专注于优化用户指定区域的运动控制,保持其他区域的生成质量。DragAnything的项目地址

项目官网:https://weijiawu.github.io/draganythingGitHub仓库:https://github.com/showlab/DragAnythingarXiv技术论文:https://arxiv.org/pdf/2403.07420DragAnything的应用场景

视频创作与编辑:快速生成动画、调整物体运动轨迹,提升创作效率。游戏开发:生成角色动作和增强玩家的交互体验。教育与培训:辅助科学模拟和技能培训,帮助理解复杂运动过程。广告与营销:制作动态广告和产品展示,突出产品特点。娱乐与社交:生成互动视频和控制虚拟角色动作,增强趣味性。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- DragAnything – 快手联合浙大等机构开源的可控视频生成方法

- GENERator – 阿里 AI for Science 团队等推出的生成式 DNA 大模型

- FoloUp – 开源AI语音面试平台,自动生成定制化面试问题

- ConsistentDreamer – 华为推出的单张图像生成 3D 资产技术

- Cline – AI编程助手,集成于 VSCode 实时检查语法错误

- 腾讯混元T1 – 腾讯混元推出的最新深度思考模型

- ImageRAG – 基于检索增强生成的图像生成技术

- X-R1 – 基于强化学习的低成本训练框架

- Step-Video-T2V – 阶跃星辰开源的文本到视频模型

- unsloth – 开源的大语言模型微调工具