AnyCharV – 港中文联合清华等机构推出的角色可控视频生成框架

2025-03-19 12:25:24 小编:六六导航站

AnyCharV是什么

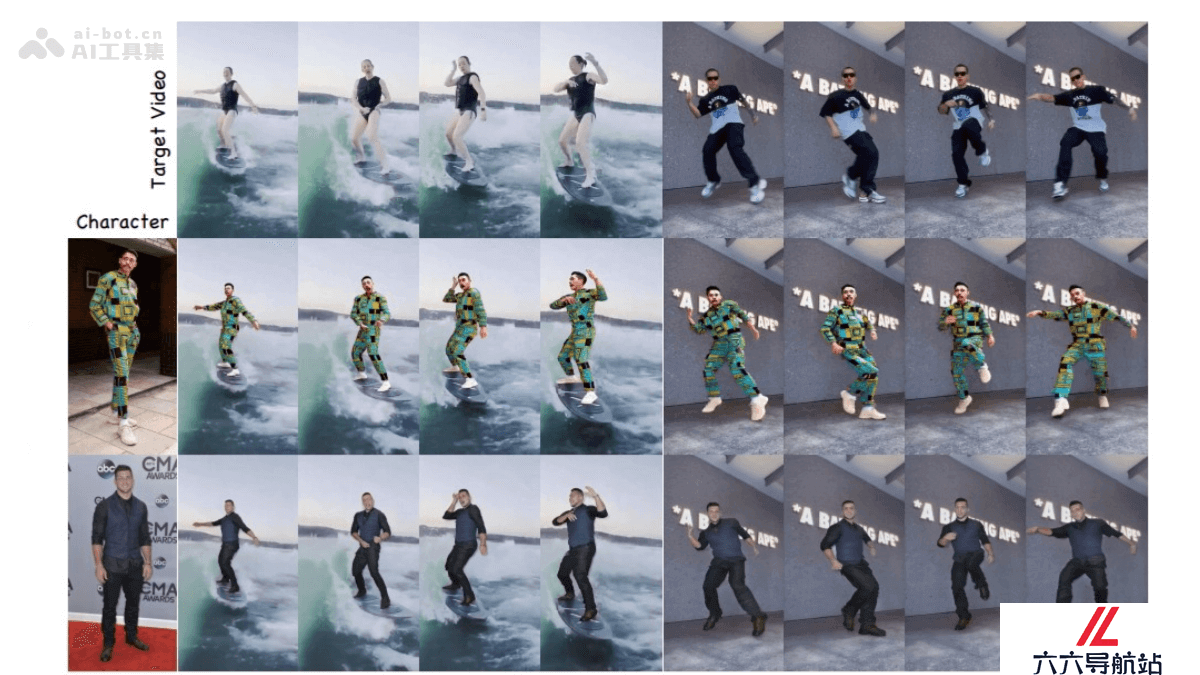

AnyCharV是香港中文大学、清华大学深圳国际研究生院、香港大学联合推出的角色可控视频生成框架,能将任意参考角色图像与目标驱动视频相结合,生成高质量的角色视频。AnyCharV基于两阶段训练策略实现精细到粗略的引导:第一阶段用细粒度分割掩码和姿态信息进行自监督合成;第二阶段用自增强训练和粗粒度掩码优化角色细节保留。AnyCharV 在实验中展现出优越的性能,能自然地保留角色的外观细节,支持复杂的人-物交互和背景融合。AnyCharV能与文本到图像(T2I)和文本到视频(T2V)模型生成的内容结合,具有很强的泛化能力。

AnyCharV的主要功能

任意角色与目标场景的合成:将任意给定的角色图像与目标驱动视频结合,生成自然、高质量的视频。高保真角色细节保留:基于自增强训练和粗粒度掩码引导,保留角色的外观和细节,避免失真。复杂场景与人-物交互:支持角色在复杂背景下的自然交互,如运动、物体操作等。灵活的输入支持:结合文本到图像(T2I)和文本到视频(T2V)模型生成的内容,具有很强的泛化能力。AnyCharV的技术原理

第一阶段:自监督合成与细粒度引导:用目标角色的分割掩码和姿态信息作为条件信号,将参考角色精确地合成到目标场景中。引入参考图像的 CLIP 特征和 ReferenceNet 提取的角色外观特征,保留角色的身份和外观。对分割掩码进行强增强,减少因形状差异导致的细节丢失。第二阶段:自增强训练与粗粒度引导基于生成的视频对进行自增强训练,用粗略的边界框掩码代替细分割掩码,减少对角色形状的约束。基于这种方式,模型能更好地保留参考角色的细节,在推理阶段生成更自然的视频。AnyCharV的项目地址

项目官网:https://anycharv.github.io/GitHub仓库:https://github.com/AnyCharV/AnyCharVarXiv技术论文:https://arxiv.org/pdf/2502.08189AnyCharV的应用场景

影视制作:将任意角色合成到目标场景,支持复杂交互,助力特效制作。艺术创作:结合文本生成内容,快速生成高质量角色视频,激发创意。虚拟现实:实时生成角色与虚拟场景的交互视频,增强沉浸感。广告营销:快速合成个性化广告视频,满足多样化需求。教育培训:生成特定角色和场景的视频,辅助教学和培训。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- AnyCharV – 港中文联合清华等机构推出的角色可控视频生成框架

- NobodyWho – AI游戏引擎插件,本地运行 LLM 实现互动小说创作

- PIKE-RAG – 微软亚洲研究院推出的检索增强型生成框架

- Collaborative Gym – 支持人与AI代理实时交互协作的评估框架

- TIGER – 清华大学推出的轻量级语音分离模型

- NPOA – 开源舆情检测工具,实时监控网络舆情与分析

- Long-VITA – 腾讯优图联合南大、厦大开源的多模态模型

- WiseDiag – 杭州智诊科技推出全球领先的医疗大模型

- CustomVideoX – 中科大联合浙大等推出的个性化视频生成框架

- KTransformers – 清华开源的大语言模型推理优化框架

- 精选推荐

-

元典智库2024-12-31法律助手

元典智库2024-12-31法律助手 -

WiziShop2025-02-02法律助手

WiziShop2025-02-02法律助手 -

Endel2025-02-25提示指令

Endel2025-02-25提示指令 -

Voice.ai2025-02-14提示指令

Voice.ai2025-02-14提示指令 -

Awesome ChatGPT Prompts2025-01-02提示指令

Awesome ChatGPT Prompts2025-01-02提示指令 -

Co-Writer AI2025-02-12法律助手

Co-Writer AI2025-02-12法律助手