Tarsier2 – 字节跳动推出的视觉理解大模型

2025-03-26 11:11:24 小编:六六导航站

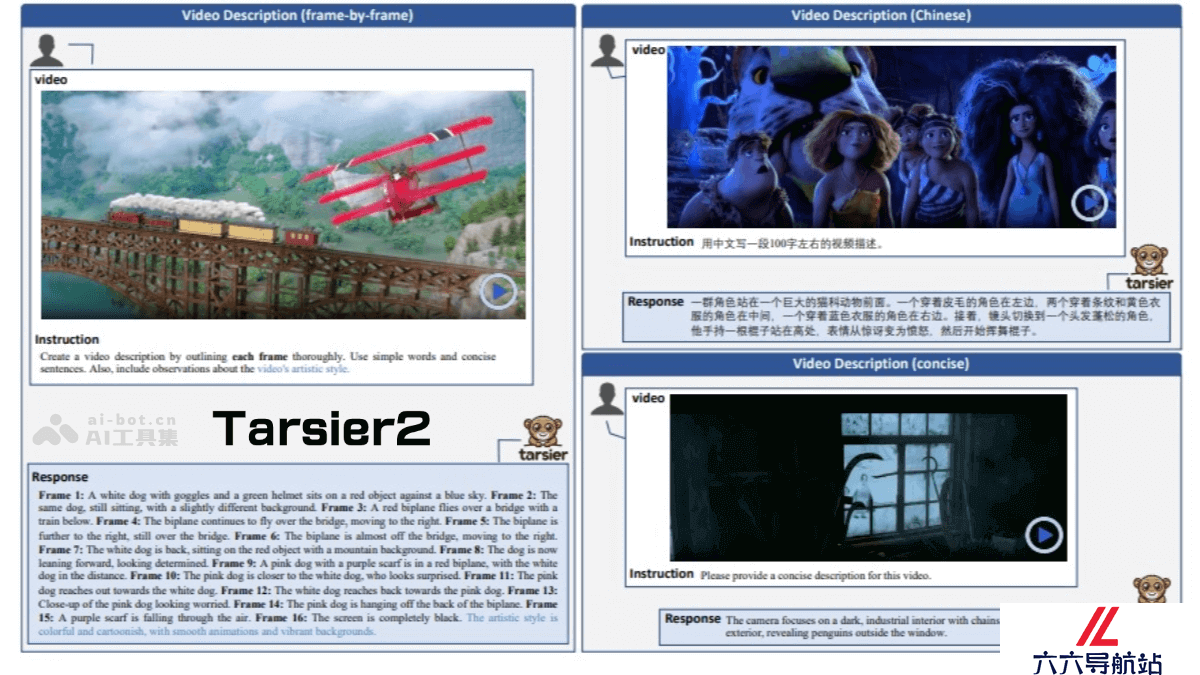

Tarsier2是什么

Tarsier2是字节跳动推出的先进的大规模视觉语言模型(LVLM),生成详细且准确的视频描述,在多种视频理解任务中表现出色。模型通过三个关键升级实现性能提升,将预训练数据从1100万扩展到4000万视频文本对,丰富了数据量和多样性;在监督微调阶段执行精细的时间对齐;基于模型采样自动构建偏好数据,应用直接偏好优化(DPO)训练。 在DREAM-1K基准测试中,Tarsier2-7B的F1分数比GPT-4o高出2.8%,比Gemini-1.5-Pro高出5.8%。在15个公共基准测试中取得了新的最佳结果,涵盖视频问答、视频定位、幻觉测试和具身问答等任务。

Tarsier2的主要功能

详细视频描述:Tarsier2能生成高质量的视频描述,覆盖视频中的各种细节,包括动作、场景和情节。视频问答:能回答关于视频的具体问题,展现出强大的时空理解和推理能力。视频定位:Tarsier2可以检测并定位视频中特定事件的发生时间,支持多视频段的定位。幻觉测试:通过优化训练策略,Tarsier2显著减少了模型生成虚假信息的可能性。多语言支持:支持多种语言的视频描述生成,进一步拓展了其应用场景。Tarsier2的技术原理

大规模预训练数据:Tarsier2将预训练数据从1100万扩展到4000万视频-文本对,提升了数据的规模和多样性。数据包括来自互联网的短视频、电影或电视剧的解说视频,通过多模态LLM自动生成的视频描述和问答对。细粒度时间对齐的监督微调(SFT):在监督微调阶段,Tarsier2引入了15万条细粒度标注的视频描述数据,每条描述都对应具体的时间戳。时间对齐的训练方式显著提高了模型在视频描述任务中的准确性和细节捕捉能力,同时减少了生成幻觉。直接偏好优化(DPO):Tarsier2通过模型采样自动构建偏好数据,应用直接偏好优化(DPO)进行训练。基于模型生成的正负样本对,进一步优化模型的生成质量,确保生成的视频描述更符合人类的偏好。Tarsier2的项目地址

GitHub仓库:https://github.com/bytedance/tarsierarXiv技术论文:https://arxiv.org/pdf/2501.07888Tarsier2的应用场景

视频描述:Tarsier2 能生成高质量的详细视频描述,涵盖视频中的各种细节,包括动作、场景和情节。幻觉测试:Tarsier2 在减少生成幻觉方面表现出色。通过直接偏好优化(DPO)和细粒度时间对齐的训练,Tarsier2 显著降低了生成虚假信息的可能性。多语言支持:Tarsier2 支持多语言的视频描述生成,能满足不同语言环境下的需求。具身问答:Tarsier2 在具身问答(Embodied QA)任务中也表现出色,能结合视觉和语言信息,为具身智能体提供准确的指导。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- Tarsier2 – 字节跳动推出的视觉理解大模型

- 硅谷一夜解禁RoboTaxi所有限制,夺回全球无人车中心

- VideoLLaMA3 – 阿里达摩院推出的多模态基础模型

- Baichuan-Omni-1.5 – 百川智能开源的全模态理解模型

- 腾讯云大模型领域新动向!向量数据库作为独立产品推出,8月上架

- TeleAI-t1-preview – 中国电信推出的复杂推理大模型

- Qwen2.5-1M – 阿里通义千问开源的语言模型,支持100万Tokens上下文

- 数学能力超ChatGPT,70B开源大模型火了:用AI微调AI,微软全华班出品

- CityDreamer4D – 南洋理工推出的无边界 4D 城市建模框架

- DiffuEraser – 阿里通义实验室推出的视频修复模型