EMO2 – 阿里研究院推出的音频驱动头像视频生成技术

2025-03-26 15:37:38 小编:六六导航站

EMO2是什么

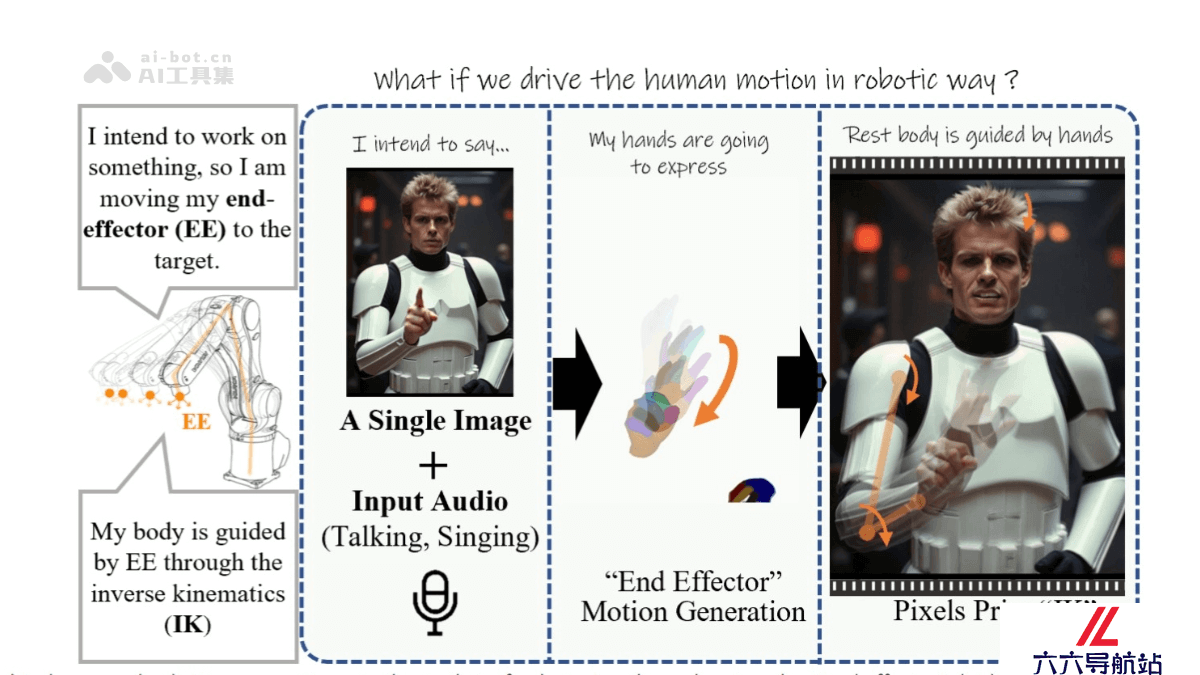

EMO2 (End-Effector Guided Audio-Driven Avatar Video Generation)是阿里巴巴智能计算研究院开发的音频驱动头像视频生成技术,全称为“末端效应器引导的音频驱动头像视频生成”。通过音频输入和一张静态人像照片,生成富有表现力的动态视频。核心创新在于将音频信号与手部动作和面部表情相结合,通过扩散模型合成视频帧,生成自然流畅的动画。 包括高质量的视觉效果、高精度的音频同步以及丰富的动作多样性。

EMO2的主要功能

音频驱动的动态头像生成:EMO2 能通过音频输入和一张静态人像照片,生成富有表现力的动态头像视频。高质量视觉效果:基于扩散模型合成视频帧,结合手部动作生成自然流畅的面部表情和身体动作。高精度音频同步:确保生成的视频与音频输入在时间上高度同步,提升整体的自然感。多样化动作生成:支持复杂且流畅的手部和身体动作,适用于多种场景。EMO2的技术原理

音频驱动的运动建模:EMO2 通过音频编码器将输入的音频信号转换为特征嵌入,捕捉音频中的情感、节奏和语义信息。末端效应器引导:该技术特别关注手部动作(末端效应器)的生成,因为手部动作与音频信号之间存在强相关性。模型首先生成手部姿势,然后将其融入整体的视频生成过程中,确保动作的自然性和一致性。扩散模型与特征融合:EMO2 采用扩散模型作为核心生成框架。在扩散过程中,模型结合参考图像的特征、音频特征以及多帧噪声,通过反复去噪操作生成高质量的视频帧。帧编码与解码:在帧编码阶段,ReferenceNet 从输入的静态图像中提取面部特征,这些特征与音频特征结合后进入扩散过程。最终,模型通过解码生成具有丰富表情和自然动作的视频。EMO2的项目地址

项目官网:https://humanaigc.github.io/emote-portrait-alive-2/arXiv技术论文:https://arxiv.org/pdf/2501.10687EMO2的应用场景

虚拟现实和动画:可用于生成富有表现力和自然的说话头像动画。跨语言和文化:支持多种语言的语音输入,能够为不同风格的人物生成动画。角色扮演和游戏:可以将指定角色应用于电影和游戏场景中。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- EMO2 – 阿里研究院推出的音频驱动头像视频生成技术

- PaSa – 字节跳动推出的学术论文检索智能体

- 首次引入视觉定位,实现细粒度多模态联合理解,已开源&demo可玩

- Baichuan-M1-preview – 百川智能推出的国内首个全场景深度思考模型

- TokenVerse – DeepMind等机构推出的多概念个性化图像生成方法

- Baichuan-M1-14B – 百川智能推出的行业首个开源医疗增强大模型

- 四个00后的疯狂开源计划:整个互联网转成大模型语料,1亿token嵌入成本只需1美元

- CogVideoX-2 – 智谱 AI 推出的文本到视频生成模型

- 中国首份仿生机器人产业全景报告发布!大模型带来加速度,三大指标决定竞争格局

- llmware – 专为企业级应用设计的开源统一框架

- 精选推荐

-

元典智库2024-12-31法律助手

元典智库2024-12-31法律助手 -

Noise Eraser2025-02-18提示指令

Noise Eraser2025-02-18提示指令 -

通义千问2025-01-30提示指令

通义千问2025-01-30提示指令 -

Copypage2025-02-19法律助手

Copypage2025-02-19法律助手 -

Content Writer Tools2025-01-30法律助手

Content Writer Tools2025-01-30法律助手 -

Guide.AI2025-02-21提示指令

Guide.AI2025-02-21提示指令