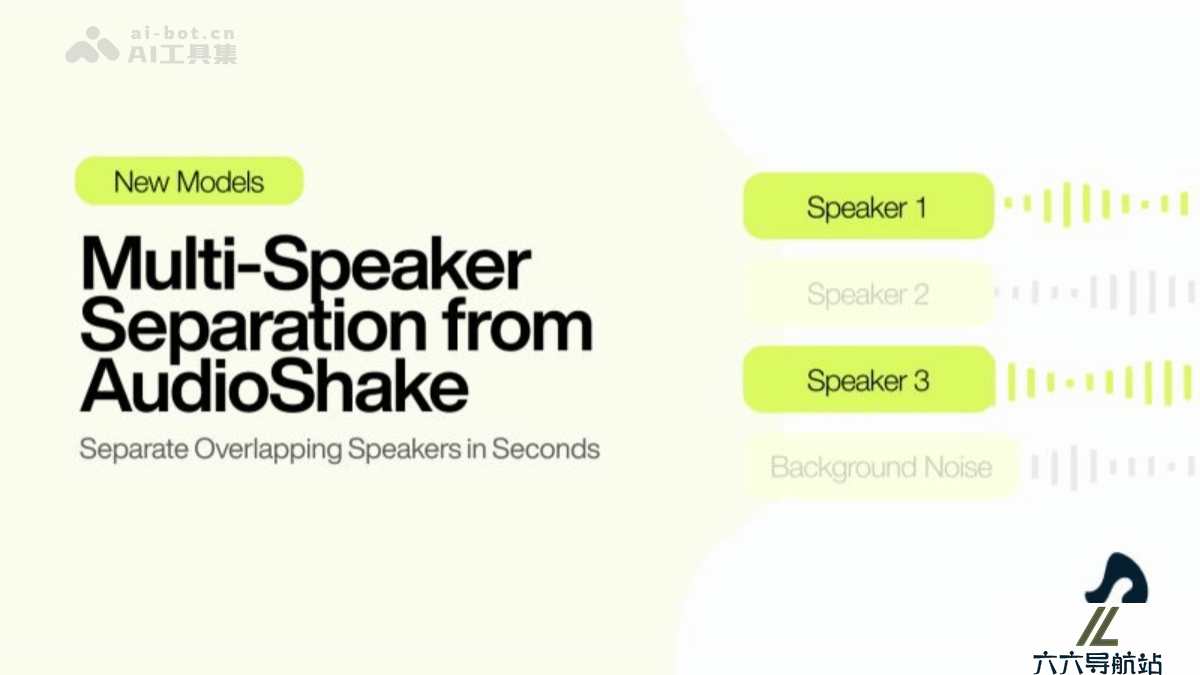

Multi-Speaker – AudioShake 推出的多说话人声分离模型

2025-04-27 14:14:02 小编:六六导航站

Multi-Speaker是什么

Multi-Speaker是AudioShake推出的全球首个高分辨率多说话人分离模型。支持将音频中的多个说话人精准分离到不同轨道,解决传统音频工具在处理重叠语音时的难题。Multi-Speaker适用于多种场景,先进神经架构支持高采样率,适合广播级音频,支持处理长达数小时的录音,在高重叠和低重叠场景,保持一致的分离效果,为音频编辑和创作带来革命性变革。Multi-Speaker已正式开放,支持用户基于AudioShake Live和AudioShake的API接口接入使用。

Multi-Speaker的主要功能

说话人分离:将不同说话人的语音分别提取到独立的音频轨道,便于单独编辑、调整音量或进行特效处理。对话清理:去除背景噪音和其他干扰,提供清晰的对话轨道,提升音频质量。高保真音频处理:支持高采样率,确保分离后的音频适合广播级和高质量音频制作。长时录音处理:处理长达数小时的录音,保持一致的分离效果。Multi-Speaker的技术原理

深度学习模型:基于深度学习算法,用大量音频数据训练模型,识别和分离不同说话人的语音特征。说话人识别与分离:模型检测音频中的不同说话人,将语音分别提取到独立的轨道。分析语音的声学特征(如音色、音调、节奏等)区分不同的说话人。高采样率处理:支持高采样率(如44.1kHz或48kHz),确保分离后的音频质量达到广播级标准。动态处理能力:处理各种复杂场景,包括高重叠对话、背景噪音和长时间录音。模型基于优化算法,确保在不同场景下保持稳定的分离效果。Multi-Speaker的项目地址

项目官网:https://www.audioshake.ai/post/introducing-multi-speakerMulti-Speaker的应用场景

影视制作:分离多说话人对话,便于后期编辑和配音。播客制作:清理录音,分离嘉宾语音,提升音质。无障碍服务:帮助残障人士用自己的声音交流。用户生成内容(UGC):分离多说话人音频,便于创作者编辑。转录与字幕制作:减少字幕错误,提高字幕准确性。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- Multi-Speaker – AudioShake 推出的多说话人声分离模型

- UniAct – 清华、商汤、北大、上海AI Lab共同推出的具身基础模型框架

- ReCamMaster – 浙大联合快手等推出的视频重渲染框架

- Stable Virtual Camera – Stability AI 等机构推出的 AI 模型,2D图像转3D视频

- Instella – AMD开源的30亿参数系列语言模型

- Maestro – 开源的端到端自动化测试框架

- OLMo 2 32B – Ai2 推出的最新开源语言模型

- InternVL – OpenGVLab 推出的多模态大模型

- Umi-OCR – 免费 OCR 文字识别工具,支持截图、批量图片排版解析

- Orpheus TTS – 开源AI语音合成系统,支持多种语音风格

- 精选推荐

-

元典智库2024-12-31法律助手

元典智库2024-12-31法律助手 -

Podcastle2025-02-17提示指令

Podcastle2025-02-17提示指令 -

NameGPT名称生成器2025-01-28提示指令

NameGPT名称生成器2025-01-28提示指令 -

Tugan.ai2025-02-18法律助手

Tugan.ai2025-02-18法律助手 -

免费AI写作2025-01-29法律助手

免费AI写作2025-01-29法律助手 -

Create AI Voiceovers2025-02-21提示指令

Create AI Voiceovers2025-02-21提示指令