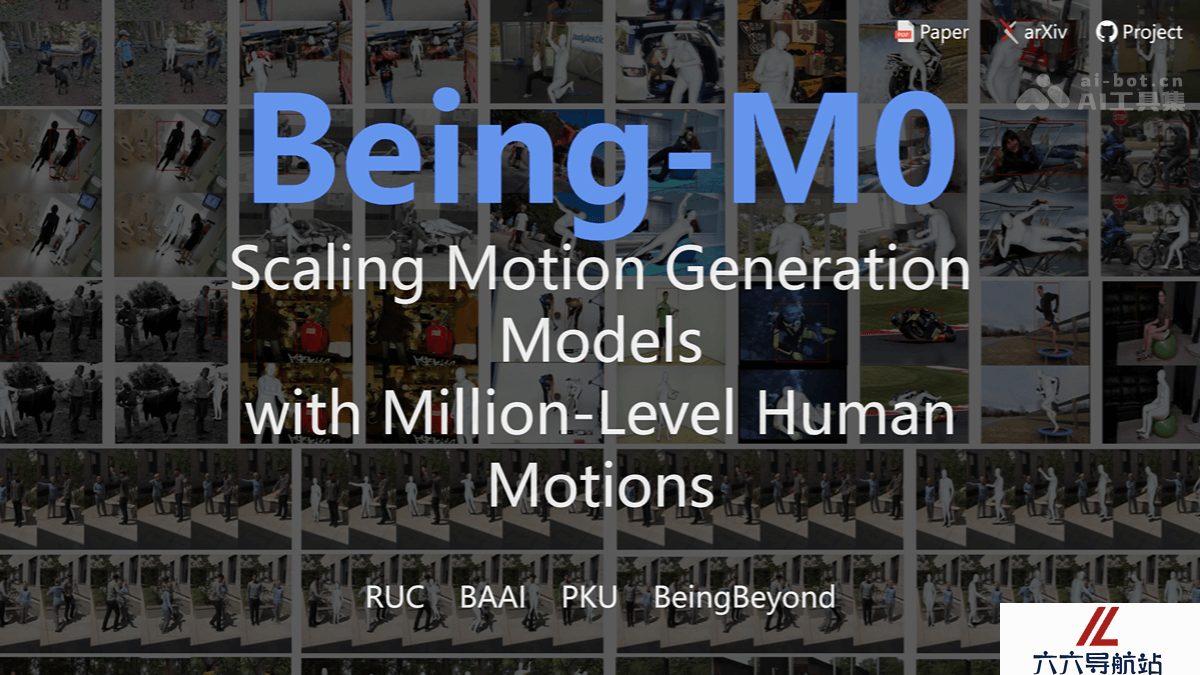

Being-M0 – 北大联合人民大学推出的人形机器人通用动作生成模型

2025-05-15 13:10:27 小编:六六导航站

Being-M0是什么

Being-M0 是北京大学、中国人民大学等机构联合推出的首个大规模人形机器人通用动作生成模型。Being-M0 基于业界首个百万级动作数据集 MotionLib,用创新的 MotionBook 编码技术,将动作序列转化为二维图像进行高效表示和生成。Being-M0 验证了大数据+大模型在动作生成领域的技术可行性,显著提升动作生成的多样性和语义对齐精度,实现从人体动作到多款人形机器人的高效迁移,为通用动作智能奠定基础。

Being-M0的主要功能

文本驱动动作生成:根据输入的自然语言描述生成相应的人类动作序列。动作迁移:模型将生成的人类动作迁移到多种人形机器人平台上,如Unitree H1、H1-2、G1等,让机器人执行类似的人类动作。多模态数据支持:Being-M0支持多种模态的数据,包括RGB视频、深度信息等,能处理多人交互场景,为复杂场景下的动作生成提供支持。Being-M0的技术原理

大规模数据集 MotionLib:基于业界首个百万级动作生成数据集 MotionLib,数据集包含超过120万条动作序列,是现有最大公开数据集的15倍。数据集基于自动化处理流程从公开数据集和在线平台收集,进行细粒度的标注。MotionBook 编码技术:基于 MotionBook 编码技术,将动作序列建模为单通道二维动作图像,分别在时间轴和关节轴构建独立编码空间,完整保留运动的**结构特征。基于降维投影消除传统codebook查找环节,让动作词表容量提升两个数量级。优化+学习的两阶段解决方案:在动作迁移方面,用优化、学习的两阶段解决方案。优化阶段基于多目标优化方法生成满足机器人运动学约束的动作序列;学习阶段用轻量级MLP网络学习从人体动作到人形机器人动作的映射关系,实现高效的动作迁移。Being-M0的项目地址

项目官网:https://beingbeyond.github.io/Being-M0/arXiv技术论文:https://arxiv.org/pdf/2410.03311Being-M0的应用场景

人形机器人控制:让机器人根据文字指令完成动作。动画制作:快速生成高质量动作序列,提高制作效率。虚拟现实与增强现实:实时生成交互动作,增强沉浸感。人机交互:让机器人更好地理解人类指令,提升协作效率。运动分析与康复:辅助运动员训练和患者康复。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- Being-M0 – 北大联合人民大学推出的人形机器人通用动作生成模型

- DanceGRPO – 字节Seed联合港大推出的统一视觉生成强化学习框架

- AlphaEvolve – 谷歌 DeepMind 推出的进化编码 AI Agent

- WorldMem – 南洋理工联合北大和上海 AI Lab 推出的世界生成模型

- GPDiT – 清华北大联合阶跃星辰等推出的视频生成模型

- NodeRAG – 开源基于异构图的智能检索与生成系统

- Ev-DeblurVSR – 中科大等机构推出的视频画面增强模型

- Embodied Reasoner – 浙大联合阿里等机构推出的具身交互推理模型

- 风宇 – 中国气象局联合华为和南昌大学推出的空间天气大模型

- RepText – Liblib AI联合Shakker Labs推出的多语言视觉文本渲染框架

- 精选推荐

-

Koolio.ai2025-02-19提示指令

Koolio.ai2025-02-19提示指令 -

Soundraw2025-02-24提示指令

Soundraw2025-02-24提示指令 -

Superpower ChatGPT2025-02-01提示指令

Superpower ChatGPT2025-02-01提示指令 -

Learning Prompt2025-01-02提示指令

Learning Prompt2025-01-02提示指令 -

Epagestore.ai2025-02-05法律助手

Epagestore.ai2025-02-05法律助手 -

ChatMindAI2025-01-27提示指令

ChatMindAI2025-01-27提示指令