EchoMimicV2 – 阿里推出的开源数字人项目,能生成完整数字人半身动画

2025-01-20 15:02:08 小编:六六导航站

EchoMimicV2是什么

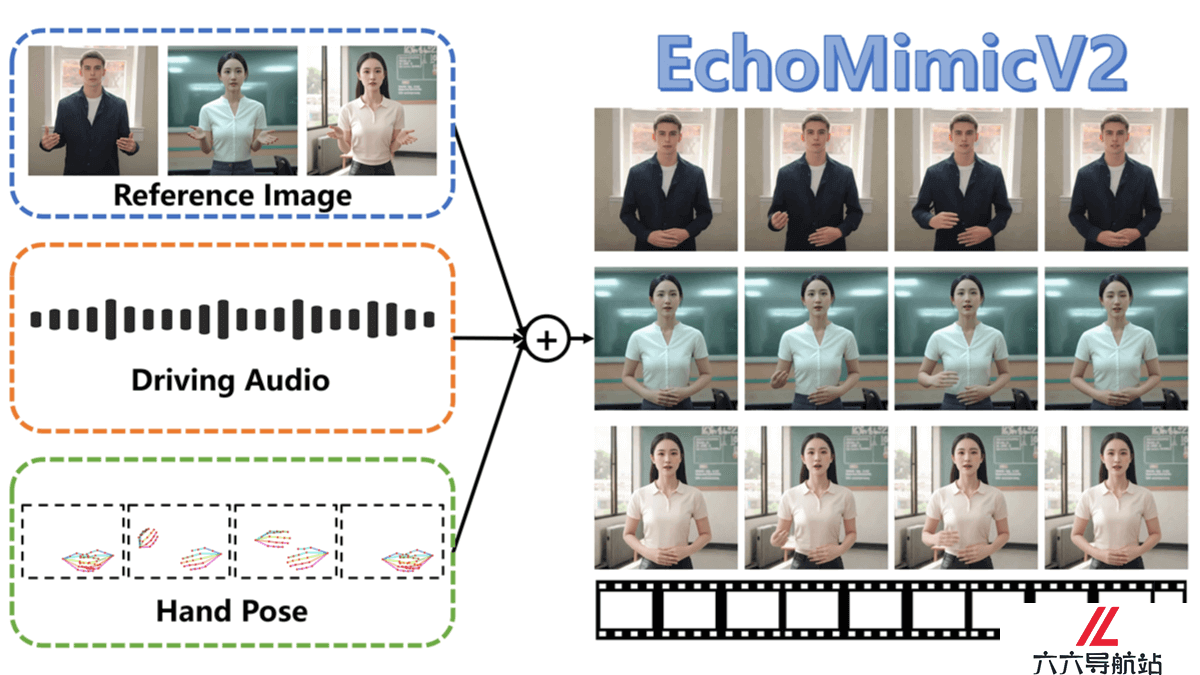

EchoMimicV2是阿里蚂蚁集团推出的半身人体AI数字人项目,基于参考图片、音频剪辑和手部姿势序列生成高质量动画视频,确保音频内容与半身动作的一致性。EchoMimicV2在前代 EchoMimicV1 生成逼真人头动画的基础上,效果得到进一步提升,现在能生成完整的数字人半身动画,实现从中英文语音到动作的无缝转换。该方法用音频-姿势动态协调策略,包括姿势采样和音频扩散,增强细节表现力并减少条件冗余。EchoMimicV2用头部局部注意力技术整合头部数据,设计特定阶段去噪损失优化动画质量。

EchoMimicV2的主要功能

音频驱动的动画生成:用音频剪辑驱动人物的面部表情和身体动作,实现音频与动画的同步。半身动画制作:从仅生成头部动画扩展到生成包括上半身的动画。简化的控制条件:减少动画生成过程中所需的复杂条件,让动画制作更为简便。手势和表情同步:基于手部姿势序列与音频的结合,生成自然且同步的手势和面部表情。多语言支持:支持中文和英文驱动,根据语言内容生成相应的动画。EchoMimicV2的技术原理

音频-姿势动态协调(APDH):姿势采样(Pose Sampling):逐步减少姿势条件的依赖,让音频条件在动画中扮演更重要的角色。音频扩散(Audio Diffusion):将音频条件的影响从嘴唇扩散到整个面部,再到全身,增强音频与动画的同步性。头部局部注意力(Head Partial Attention, HPA):在训练中整合头部数据,增强面部表情的细节,无需额外的插件或模块。特定阶段去噪损失(Phase-specific Denoising Loss, PhD Loss):将去噪过程分为三个阶段:姿势主导、细节主导和质量主导,每个阶段都有特定的优化目标。Latent Diffusion Model(LDM):用变分自编码器(VAE)将图像映射到潜在空间,在训练过程中逐步添加噪声,估计并去除每个时间步的噪声。ReferenceNet-based Backbone:用ReferenceNet从参考图像中提取特征,将其注入到去噪U-Net中,保持生成图像与参考图像之间的外观一致性。EchoMimicV2的生成效果展示

效果一:中文音频驱动https://ai-bot.cn/wp-content/uploads/2024/11/ch_01.mp4- 猜你喜欢

-

词魂提示指令

词魂提示指令 -

ChatGPT Shortcut提示指令

ChatGPT Shortcut提示指令 -

Learning Prompt提示指令

Learning Prompt提示指令 -

-

PromptVine提示指令

PromptVine提示指令 -

-

-

MJ Prompt Tool提示指令

MJ Prompt Tool提示指令 -

绘AI提示指令

绘AI提示指令

- 相关AI应用

-

AIPRM提示指令

AIPRM提示指令 -

Snack Prompt提示指令

Snack Prompt提示指令 -

PublicPrompts提示指令

PublicPrompts提示指令 -

Generrated提示指令

Generrated提示指令 -

LangGPT提示指令

LangGPT提示指令 -

AI Short提示指令

AI Short提示指令 -

-

ClickPrompt提示指令

ClickPrompt提示指令 -

PromptHero提示指令

PromptHero提示指令

- 推荐AI教程资讯

- EchoMimicV2 – 阿里推出的开源数字人项目,能生成完整数字人半身动画

- FlipSketch – 萨里大学推出的文本引导生成无约束草图动画的AI系统

- StoryTeller – 字节、上海交大、北大共同推出的全自动长视频描述生成一致系统

- DELIFT – 数据高效语言模型指令微调算法

- HART – 麻省理工学院推出的自回归视觉生成模型

- WebDreamer – 基于大语言模型模拟网页交互增强网络规划能力的框架

- Kandinsky-3 – 开源的文本到图像生成框架,适应多种图像生成任务

- CAVIA – 苹果、得克萨斯、谷歌联合推出的多视角视频生成框架

- Flex3D – Meta GenAI和牛津大学共同推出的两阶段3D生成框架

- EvolveDirector – 阿里联合南洋理工推出文本到图像生成模型的高效训练技术

- 精选推荐

-

词魂2025-01-02提示指令

词魂2025-01-02提示指令 -

法智2025-01-02法律助手

法智2025-01-02法律助手 -

Awesome ChatGPT Prompts2025-01-02提示指令

Awesome ChatGPT Prompts2025-01-02提示指令 -

PromptPerfect2024-12-31提示指令

PromptPerfect2024-12-31提示指令 -

ChatGPT Prompt Genius2025-01-02提示指令

ChatGPT Prompt Genius2025-01-02提示指令 -

MJ Prompt Tool2025-01-02提示指令

MJ Prompt Tool2025-01-02提示指令