AnimateAnything – 浙江大学联合北航推出的统一可控视频生成技术

2025-01-22 13:28:25 小编:六六导航站

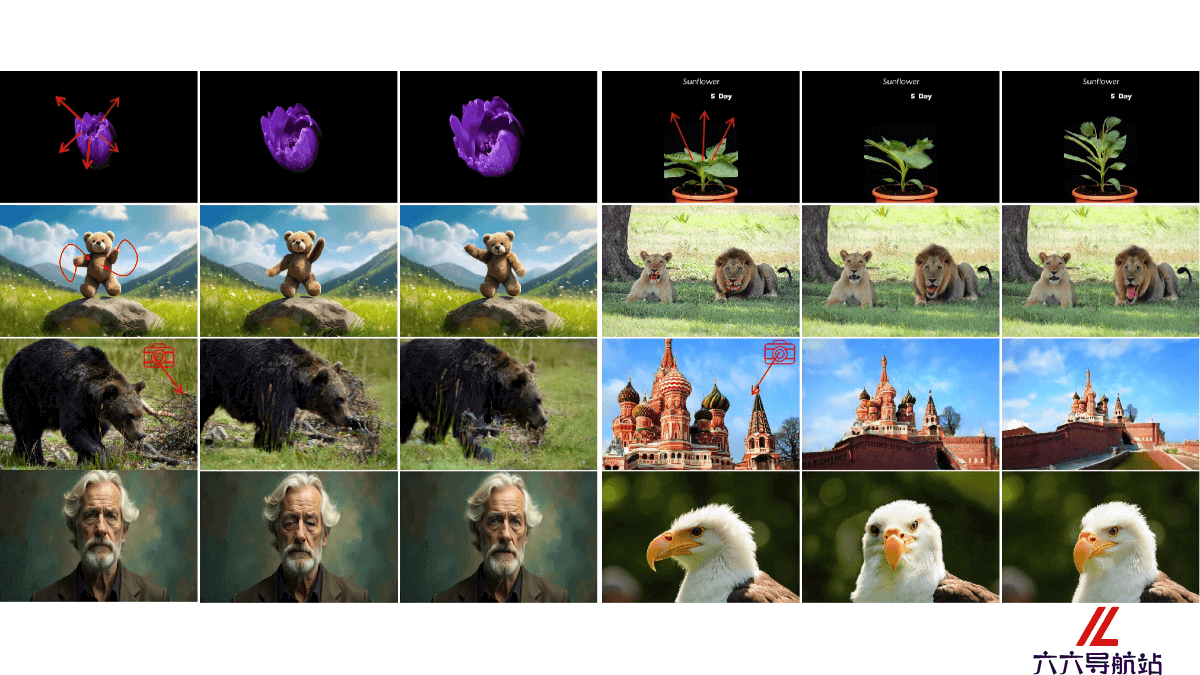

AnimateAnything是什么

AnimateAnything是浙江大学和北京航空航天大学研究者推出的统一可控视频生成技术。AnimateAnything能精确操作视频,包括控制相机轨迹、文本提示和用户动作注释。基于多尺度控制特征融合网络,该技术将控制信息转化为逐帧光流,指导视频生成。为减少大范围运动导致的闪烁,AnimateAnything提出基于频率的稳定模块。

AnimateAnything的主要功能

精确视频操作:对视频进行精确控制,包括相机轨迹、文本提示和用户动作注释等多种条件下的视频操作。多条件控制:支持将不同的控制信号(如对象运动、相机运动)统一为光流表示,简化多信号处理的复杂性。光流引导:用光流作为运动先验指导视频生成,确保视频的连贯性和一致性。闪烁问题减少:基于频率的稳定模块减少大规模运动引起的视频闪烁问题,增强视频的时间一致性。AnimateAnything的技术原理

多尺度控制特征融合网络:构建一个网络处理不同的控制信号,将其统一转换为逐帧的光流。这个网络处理显式控制信号(如基于箭头的运动注释)和隐式控制信号(如相机轨迹)。光流作为运动先验:将生成的光流作为运动先验,用于指导视频生成模型的行为,实现对视频生成过程的精确控制。基于频率的稳定模块:基于在频域中修改特征来增强时间一致性,减少由于大规模运动引起的视频闪烁和不稳定性。两阶段视频生成流程:第一阶段:将各种视觉控制信号转换为统一的光流表示。第二阶段:用生成的统一光流指导最终的视频生成,确保视频与参考图像和注释的语义一致性。频域特征修改:用快速傅里叶变换(FFT)和逆FFT(InvFFT)在频域中修改特征,保持视频生成过程中的特征一致性。AnimateAnything的项目地址

项目官网:Animate_AnythingGitHub仓库:https://github.com/yu-shaonian/AnimateAnythingarXiv技术论文:https://arxiv.org/pdf/2411.10836AnimateAnything的应用场景

电影和视频制作:在电影制作中,生成或修改视频片段,如动画角色的动作捕捉、特效制作和场景模拟,提高制作效率并降低成本。虚拟现实(VR)和增强现实(AR):在VR和AR应用中,创建更加真实和动态的虚拟环境,提供更加自然和流畅的交互体验。游戏开发:游戏开发者生成或控制游戏角色和环境的动画,提高游戏的沉浸感和可玩性。模拟和训练:在军事、航空、医疗等领域的模拟训练中,生成逼真的视频内容,用于模拟各种复杂场景,提高训练效果。教育和培训:创建教育视频和培训材料,让学习内容更加生动和易于理解。- 猜你喜欢

-

词魂提示指令

词魂提示指令 -

ChatGPT Shortcut提示指令

ChatGPT Shortcut提示指令 -

Learning Prompt提示指令

Learning Prompt提示指令 -

-

PromptVine提示指令

PromptVine提示指令 -

-

-

MJ Prompt Tool提示指令

MJ Prompt Tool提示指令 -

绘AI提示指令

绘AI提示指令

- 相关AI应用

-

AIPRM提示指令

AIPRM提示指令 -

Snack Prompt提示指令

Snack Prompt提示指令 -

PublicPrompts提示指令

PublicPrompts提示指令 -

Generrated提示指令

Generrated提示指令 -

LangGPT提示指令

LangGPT提示指令 -

AI Short提示指令

AI Short提示指令 -

-

ClickPrompt提示指令

ClickPrompt提示指令 -

PromptHero提示指令

PromptHero提示指令

- 推荐AI教程资讯

- AnimateAnything – 浙江大学联合北航推出的统一可控视频生成技术

- RAG-Diffusion – 南京大学推出的区域感知文本到图像生成方法

- FitDiT – 腾讯联合复旦推出的高保真虚拟试穿技术

- MARS – 字节推出优化大模型训练效率的框架

- Verifier Engineering – 中科院、阿里、小红书联合推出的新型后训练范式

- XiYan-SQL – 阿里推出文本到SQL的多生成器集成框架

- KuaiFormer – 快手推出的检索框架,基于Transformer

- EyeDiff – 文本到图像扩散模型,自然语言生成多模态眼科图像

- BlueLM-V-3B – ViVo联合香港中文大学推出的算法和系统协同设计方法

- AtomThink – 华为诺亚方舟联合多所高校推出的多模态数学推理框架