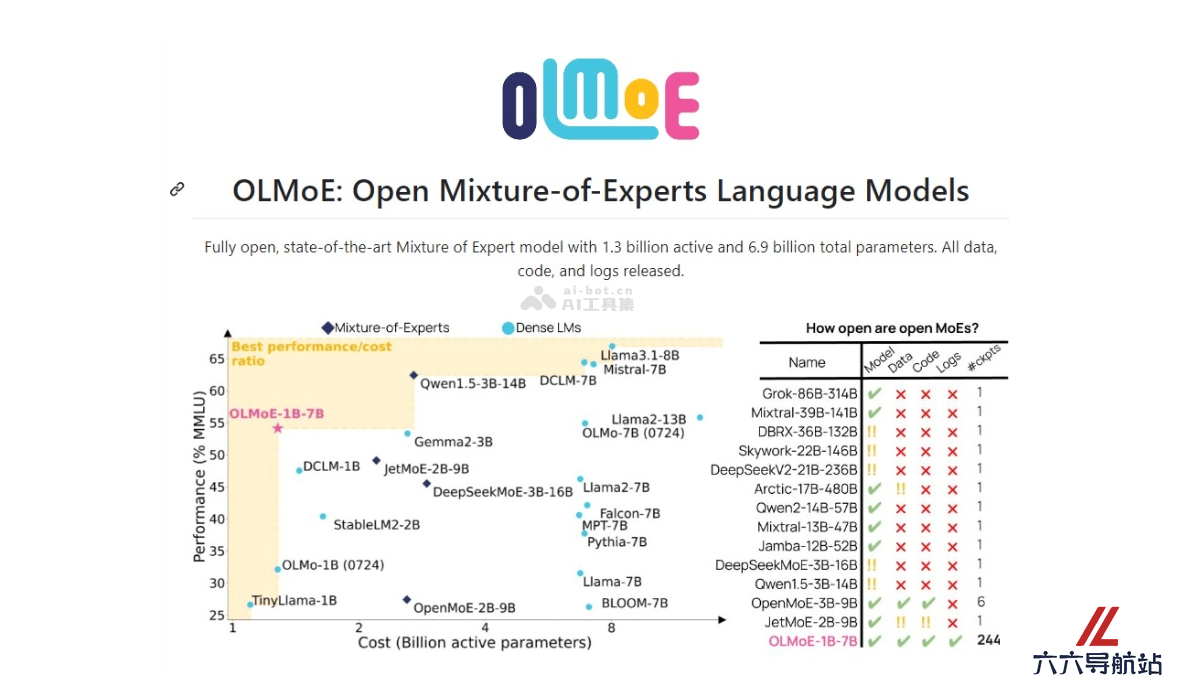

OLMoE – 完全开源的大语言模型,基于混合专家(MoE)架构

2025-02-08 11:53:32 小编:六六导航站

OLMoE是什么

OLMoE(Open Mixture-of-Experts Language Models)是一个完全开源的大型语言模型,基于混合专家(MoE)架构。OLMoE基于5万亿个token进行预训练,拥有70亿总参数和10亿活跃参数。模型在每一层中只有一部分专家根据输入被激活,比传统密集模型更高效,降低计算成本。OLMoE的设计在保持高性能的同时,训练速度更快,推理成本更低,能与更大、更昂贵的模型竞争。

OLMoE的主要功能

自然语言理解:OLMoE能理解和处理自然语言文本,识别语言中的含义和上下文。文本生成:模型生成连贯且相关的文本,用于聊天机器人、内容创作等场景。多任务处理:预训练模型在多种自然语言处理任务上进行微调,如文本分类、情感分析、问答系统等。高效推理:模型在推理时只激活必要的参数,减少计算资源的需求。快速训练:模型基于专家混合架构,实现快速训练,加速模型迭代和优化。OLMoE的技术原理

混合专家(Mixture-of-Experts, MoE):模型由多个“专家”网络组成,每个专家处理输入数据的不同部分。稀疏激活:在任何给定时间,只有一小部分专家被激活,减少模型的计算和内存需求。路由机制:模型包含一个路由算法,动态决定哪些专家应该被激活处理特定的输入。负载平衡:确保所有专家在训练过程中得到均衡的使用,防止某些专家被过度或少使用。预训练和微调:模型首先在大规模数据集上进行预训练,学习语言的通用特征,然后针对特定任务进行微调。OLMoE的项目地址

GitHub仓库:https://github.com/allenai/OLMoEarXiv技术论文:https://arxiv.org/pdf/2409.02060OLMoE的应用场景

聊天机器人:提供自然、连贯的对话体验,用在客户服务、虚拟助手和社交娱乐。内容创作:生成文章、故事、诗歌等文本内容,辅助写作和创意工作。语言翻译:将文本从一种语言翻译成另一种语言,跨语言沟通。情感分析:分析文本数据确定作者的情绪倾向,用在市场研究和客户反馈分析。文本摘要:自动生成文档、文章或报告的摘要,节省阅读时间。问答系统:快速检索信息并回答用户的查询,用在在线帮助中心和知识库。- 猜你喜欢

-

GPT Stylist提示指令

GPT Stylist提示指令 -

-

-

FictionGPT提示指令

FictionGPT提示指令 -

-

Embra提示指令

Embra提示指令 -

ChatGPT Super提示指令

ChatGPT Super提示指令 -

DapperGPT提示指令

DapperGPT提示指令 -

IMI Prompt提示指令

IMI Prompt提示指令

- 相关AI应用

-

Enhanced ChatGPT提示指令

Enhanced ChatGPT提示指令 -

Ghostwrite提示指令

Ghostwrite提示指令 -

悟智写作提示指令

悟智写作提示指令 -

-

BraveGPT提示指令

BraveGPT提示指令 -

ChatGPT Sidebar提示指令

ChatGPT Sidebar提示指令 -

Prompt Genie提示指令

Prompt Genie提示指令 -

RoleD提示指令

RoleD提示指令 -

2233.ai提示指令

2233.ai提示指令

- 推荐AI教程资讯

- OLMoE – 完全开源的大语言模型,基于混合专家(MoE)架构

- WebDesignAgent – 自动化网页设计AI工具,零门槛搭建各类型网站

- Bolt․new – AI全栈 Web 编程工具,自动写代码、运行、部署

- ChatMLX – 高性能MacOS聊天应用,基于MLX框架实现与数据实时交互

- anime.gf – AI虚拟角色创建与互动的开源应用

- CDial-GPT – 清华推出的大型中文短文本对话数据集和对话生成模型

- RD-Agent – 微软亚洲研究院推出开源的自动化研究与开发工具

- FLUX1.1 – Black Forest Labs团队推出的超写实AI图像生成模型,代号“蓝莓”

- Realtime API – OpenAI推出的实时语音交互API

- Laminar – 分析与优化LLM应用程序的开源平台