MDT-A2G – 复旦&腾讯优图推出的AI模型,可根据语音同步生成手势

2025-02-24 16:41:10 小编:六六导航站

MDT-A2G是什么

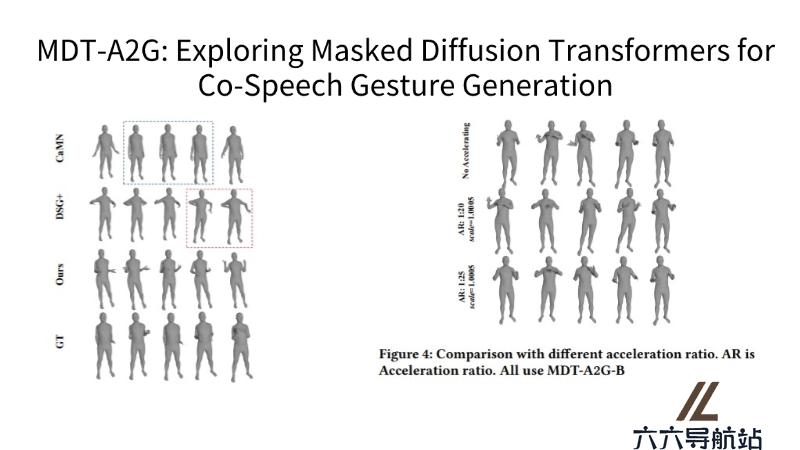

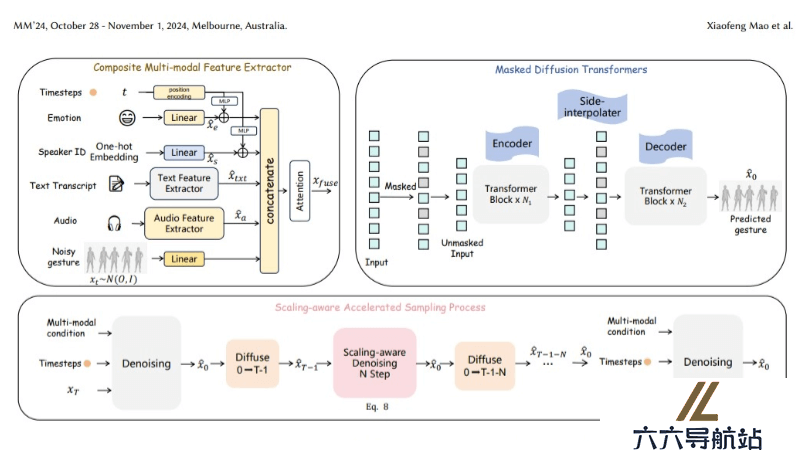

MDT-A2G是复旦大学和腾讯优图联合推出的AI模型,专门用于根据语音内容同步生成相应的手势动作。MDT-A2G模仿人类在交流时自然产生的手势,计算机能更加生动和自然地进行”表演”。MDT-A2G用语音、文本、情感等多种信息进行综合分析,通过去噪和加速采样等技术,生成连贯逼真的手势序列。

MDT-A2G的主要功能

多模态信息融合:结合语音、文本、情感等多种信息源,进行综合分析,生成与语音同步的手势。去噪处理:通过去噪技术,修正和优化手势动作,确保生成的手势动作准确且自然。加速采样:采用高效的推理策略,利用先前计算的结果来减少去噪计算量,实现快速生成。时间对齐的上下文推理:强化手势序列之间的时间关系学习,产生连贯且逼真的动作。MDT-A2G的技术原理

多模态特征提取:模型从语音、文本、情感等多种信息源中提取特征。涉及到语音识别技术来转换语音为文本,以及情感分析来识别说话人的情绪状态。掩蔽扩散变换器:MDT-A2G使用一种新型的掩蔽扩散变换器结构。通过在数据中引入随机性,然后逐步去除这些随机性来生成目标输出,类似于去噪过程。时间对齐和上下文推理:模型需要理解语音和手势之间的时间关系,确保手势与语音同步。涉及到序列模型,能够处理时间序列数据并学习时间依赖性。加速采样过程:为了提高生成效率,MDT-A2G采用了一种缩放感知的加速采样过程。模型用先前计算的结果来减少后续的计算量,从而加快手势生成的速度。特征融合策略:模型采用创新的特征融合策略,将时间嵌入与情感和身份特征结合起来,并与文本、音频和手势特征相结合,产生全面的特征表示。去噪过程:在生成手势的过程中,模型会逐步去除噪声,优化手势动作,确保生成的手势既准确又自然。

MDT-A2G的项目地址

GitHub仓库:https://github.com/sail-sg/MDT- 猜你喜欢

- 相关AI应用

-

Guide.AI提示指令

Guide.AI提示指令 -

-

Aflorithmic提示指令

Aflorithmic提示指令 -

RadioNewsAI提示指令

RadioNewsAI提示指令 -

-

Respeecher提示指令

Respeecher提示指令 -

Supertone提示指令

Supertone提示指令 -

-

Voice Swap提示指令

Voice Swap提示指令

- 推荐AI教程资讯

- MDT-A2G – 复旦&腾讯优图推出的AI模型,可根据语音同步生成手势

- ASAM – vivo公司推出的AI图像分割模型

- Falcon Mamba 7B – 首个通用Mamba开源AI大模型

- Clapper – 免费开源的可视化AI视频编辑工具

- UniTalker – 商汤推出的音频驱动3D面部动画生成模型

- Grok-2 – xAI公司推出的新一代AI模型

- MagicPose – AI视频生成模型,能生成逼真的人体动作和面部表情

- Agent Q – MultiOn公司推出的AI智能体,可以自我学习进化

- UniPortrait – 阿里推出的AI人像图像个性化编辑工具

- LabelU – 开源的多模态数据标注工具

- 精选推荐

-

Drumloop AI2025-02-14提示指令

Drumloop AI2025-02-14提示指令 -

论文智匠2025-02-02法律助手

论文智匠2025-02-02法律助手 -

BraveGPT2025-02-05提示指令

BraveGPT2025-02-05提示指令 -

SnapGPT2025-02-12法律助手

SnapGPT2025-02-12法律助手 -

得理法搜2025-01-02法律助手

得理法搜2025-01-02法律助手 -

Voiceful.io2025-02-13提示指令

Voiceful.io2025-02-13提示指令