GameFactory – 香港大学和快手联合推出的可泛化游戏场景框架

2025-03-28 09:08:40 小编:六六导航站

GameFactory是什么

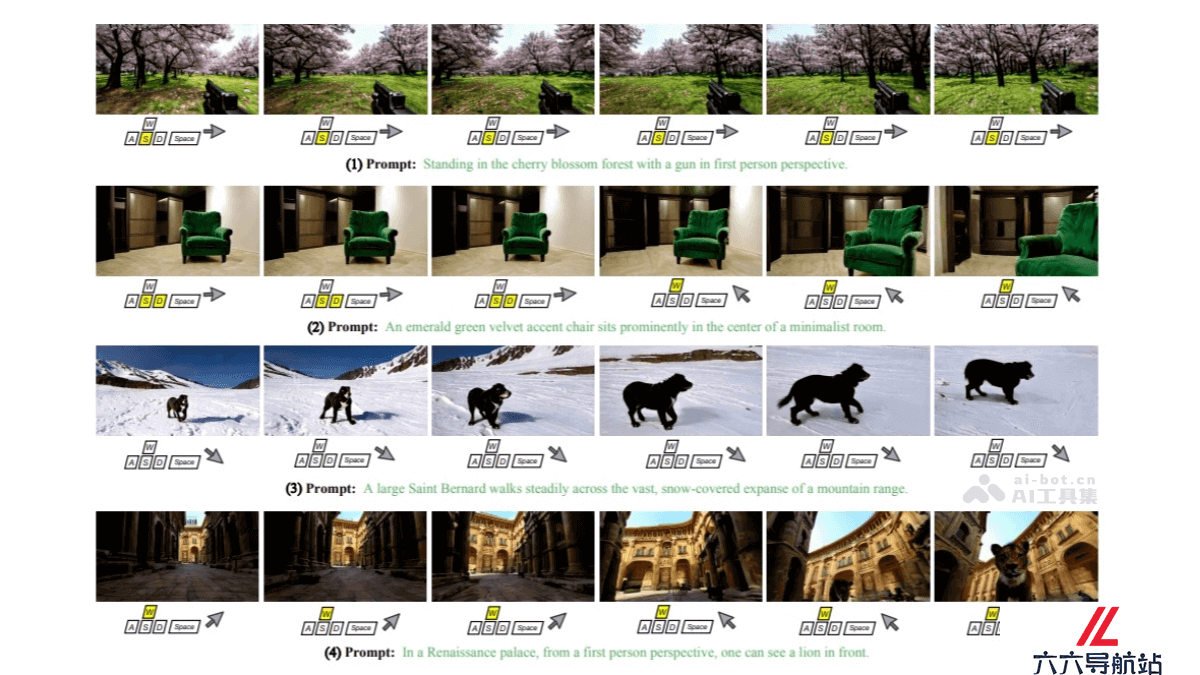

GameFactory 是香港大学和快手科技联合提出的创新框架,解决游戏视频生成中的场景泛化难题。框架基于预训练的视频扩散模型,结合开放域视频数据和小规模高质量的游戏数据集,通过多阶段训练策略,实现动作可控的游戏视频生成。

GameFactory的主要功能

场景泛化能力:GameFactory 能生成多样化的游戏场景,不局限于单一风格或预设的场景。使生成的视频更具真实感和多样性。动作可控性:通过动作控制模块,GameFactory 可以实现对生成视频中角色或物体动作的精确控制。高质量数据集支持:为了支持动作可控的视频生成,GameFactory 采用了 GF-Minecraft 数据集。该数据集包含 70 小时的《我的世界》游戏视频,具有多样化的场景和详细的动作标注。交互式视频生成:GameFactory 支持生成无限长度的交互式游戏视频。用户可以通过输入指令或交互信号来控制视频内容的变化。GameFactory的技术原理

预训练视频扩散模型:GameFactory 基于在开放域视频数据上预训练的视频扩散模型,能生成多样化的游戏场景,突破了传统方法对特定游戏风格和场景的限制。三阶段训练策略第一阶段:使用 LoRA(Low-Rank Adaptation)对预训练模型进行微调,使其适应目标游戏领域,同时保留大部分原始参数。确保模型在开放域的泛化能力得以保留。第二阶段:冻结预训练参数和 LoRA,专注于训练动作控制模块,避免风格与控制信号之间的纠缠。目标是确保生成的视频能根据用户输入进行准确的动作控制。第三阶段:移除 LoRA 权重,保留动作控制模块参数,使系统能在各种开放域场景中生成受控的游戏视频,不局限于特定的游戏风格。动作控制模块:GameFactory 引入了动作控制模块,支持自回归动作控制,能生成无限长度的交互式游戏视频。GF-Minecraft 数据集:为了支持动作可控的视频生成,研究团队发布了高质量的动作标注视频数据集 GF-Minecraft。数据集包含 70 小时的《我的世界》游戏视频,具有多样化的场景和详细的动作标注。数据集的设计满足了以下三个关键需求:可定制的动作:支持大规模、低成本的数据收集。无偏的动作序列:确保动作组合的多样性和低概率事件的覆盖。多样化的场景:通过预设的环境配置(如不同的生物群落、天气条件和时间段)增强场景多样性。GameFactory的项目地址

项目官网:https://vvictoryuki.github.io/gamefactoryarXiv技术论文:https://arxiv.org/pdf/2501.08325GameFactory的应用场景

游戏开发:GameFactory 通过预训练的视频扩散模型和动作控制模块,能生成多样化的游戏场景和交互式视频内容。游戏内容创新:GameFactory 的开放域生成能力使其能够突破传统游戏引擎的限制,创造出全新的游戏风格和场景。自动驾驶:其动作控制模块和场景生成能力可以用于模拟自动驾驶环境,生成多样化的驾驶场景。具身智能(Embodied AI):通过生成多样化的交互场景,为具身智能的研究提供支持。- 猜你喜欢

-

MusicTGA-HR提示指令

MusicTGA-HR提示指令 -

RappingAI提示指令

RappingAI提示指令 -

Boomy提示指令

Boomy提示指令 -

TwoShot提示指令

TwoShot提示指令 -

Weet提示指令

Weet提示指令 -

Muzaic Studio提示指令

Muzaic Studio提示指令 -

-

HookGen提示指令

HookGen提示指令 -

DadaBots提示指令

DadaBots提示指令

- 相关AI应用

-

Playlistable提示指令

Playlistable提示指令 -

Riffusion提示指令

Riffusion提示指令 -

WZRD提示指令

WZRD提示指令 -

-

Cyanite.ai提示指令

Cyanite.ai提示指令 -

Piano Genie提示指令

Piano Genie提示指令 -

Synthesizer V提示指令

Synthesizer V提示指令 -

Cosonify提示指令

Cosonify提示指令 -

Musico提示指令

Musico提示指令

- 推荐AI教程资讯

- GameFactory – 香港大学和快手联合推出的可泛化游戏场景框架

- Step-2 mini – 阶跃星辰推出的轻量级极速大模型

- FramePainter – 哈工大联合华为诺亚推出的交互式图像编辑AI工具

- U设计周大谈AI时代的设计,不懂点大模型都落伍了

- 百聆 – AI语音对话助手,端到端时延低至800ms

- LineArt – 吉林大学等机构推出的设计绘图外观迁移框架

- 李开复麾下大模型公司零一万物上线,数十位核心成员就位

- SynthLight – 耶鲁大学联合 Adobe 推出的人像重照明技术

- X-Dyna – 字节联合斯坦福等高校推出的动画生成框架

- DeepSeek-R1 – DeepSeek推出的高性能AI推理模型,性能对标OpenAI o1正式版