AI教程资讯

-

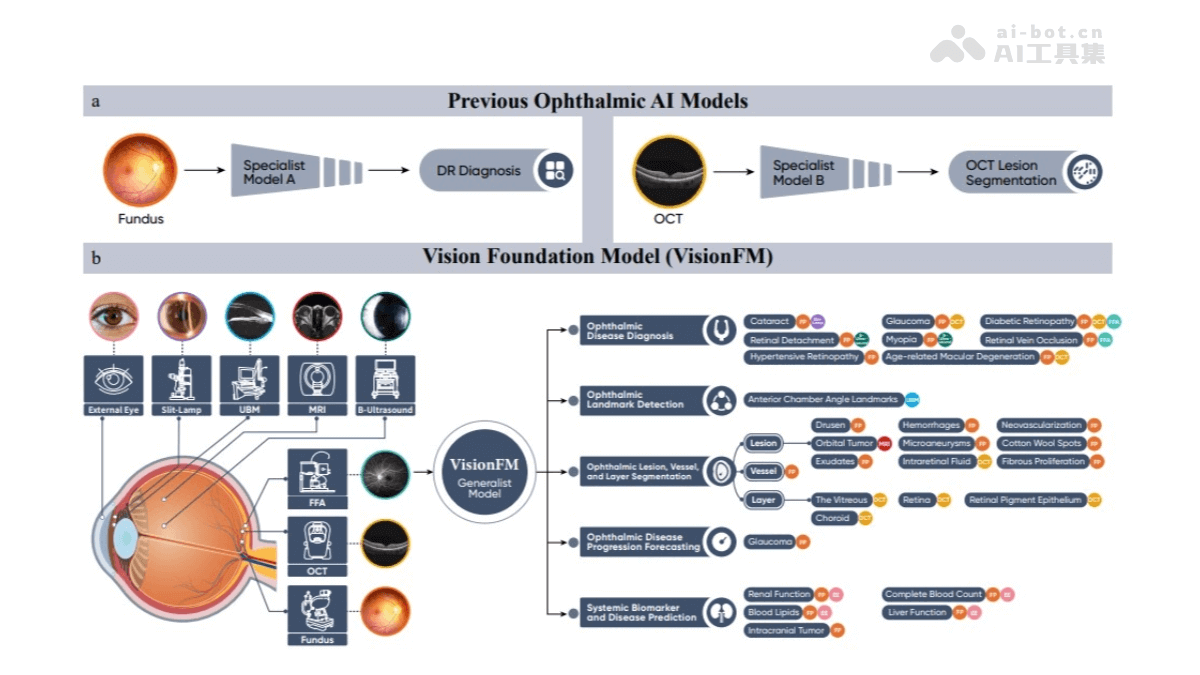

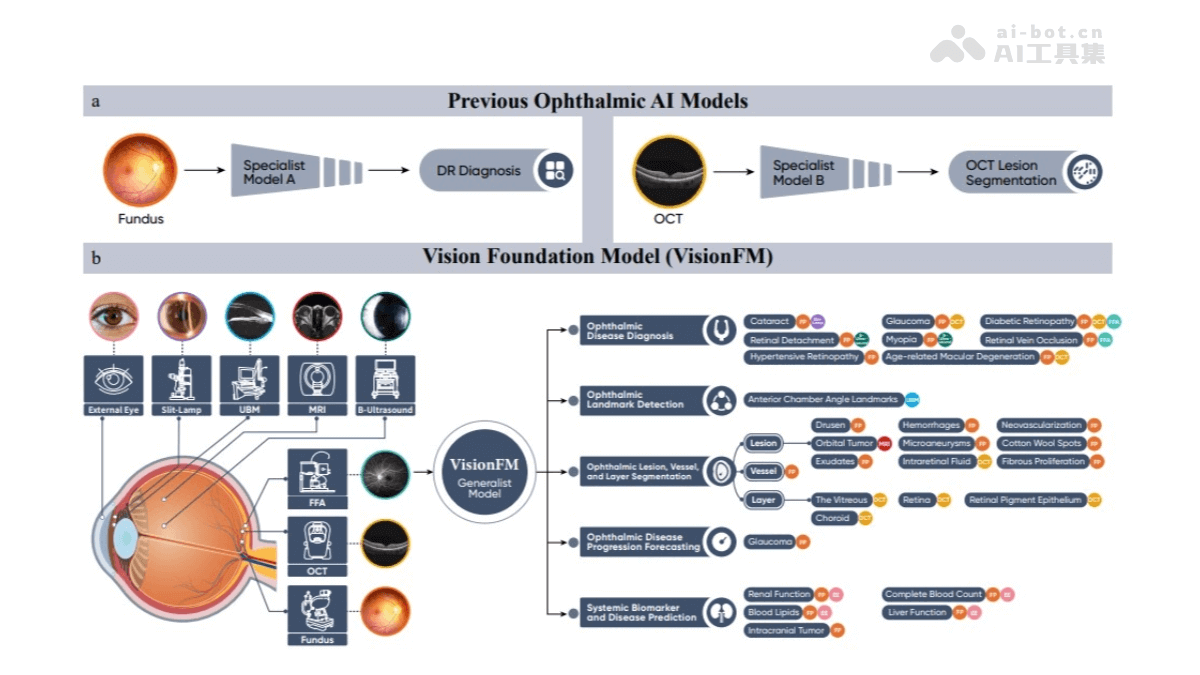

VisionFM – 通用眼科AI大模型,具备少样本多种疾病诊断能力

发表时间:2025-01-07

VisionFM(伏羲慧眼)是多模态多任务的视觉基础模型,专为通用眼科人工智能而设计。通过预训练3 4百万张来自560,457个个体的眼科图像,覆盖广泛的眼科疾病、成像模态、设备和人群统计数据。VisionFM能处理包括眼底摄影、光学相干断层扫描(OCT)、荧光素眼底血管造影(FFA)等在内的八种常见眼科成像模态,应用于眼科疾病识别、疾病进展预测、疾病表型细分以及全身生物标志物和疾病预测等多种眼科AI任务。

【全文阅读】

-

MetaMorph – 统一多模态理解与生成大模型,基于VPiT 预测多模态 token

发表时间:2025-01-07

MetaMorph是多模态大模型(MLLM),通过指令微调(Instruction Tuning)实现视觉理解和生成。它提出了一种名为Visual-Predictive Instruction Tuning(VPiT)的方法,使得预训练的大型语言模型(LLM)能够快速转变为一个统一的自回归模型,能生成文本和视觉token。

【全文阅读】

-

AgentScope – 阿里开源的多智能体开发平台

发表时间:2025-01-07

AgentScope是阿里巴巴集团开源的多智能体开发平台,帮助开发者轻松构建和部署多智能体应用。AgentScope提供高易用性、高鲁棒性和分布式支持,内置多种模型API和本地模型部署选项,覆盖聊天、图像合成、文本嵌入等多种任务。

【全文阅读】

-

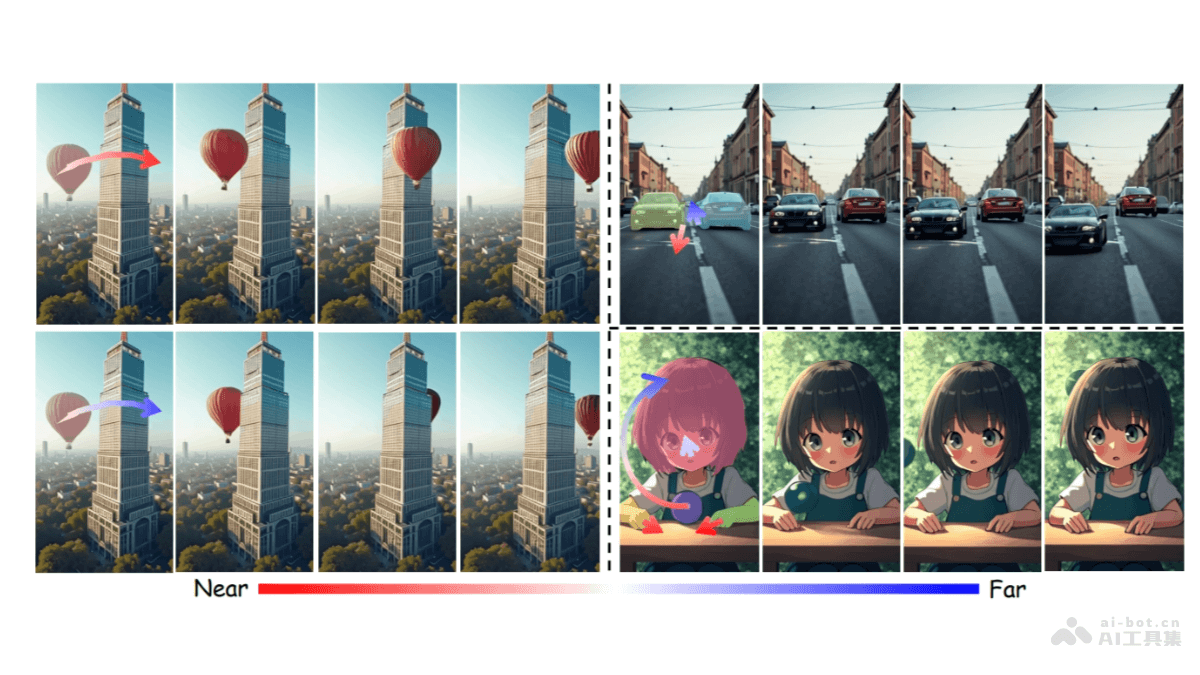

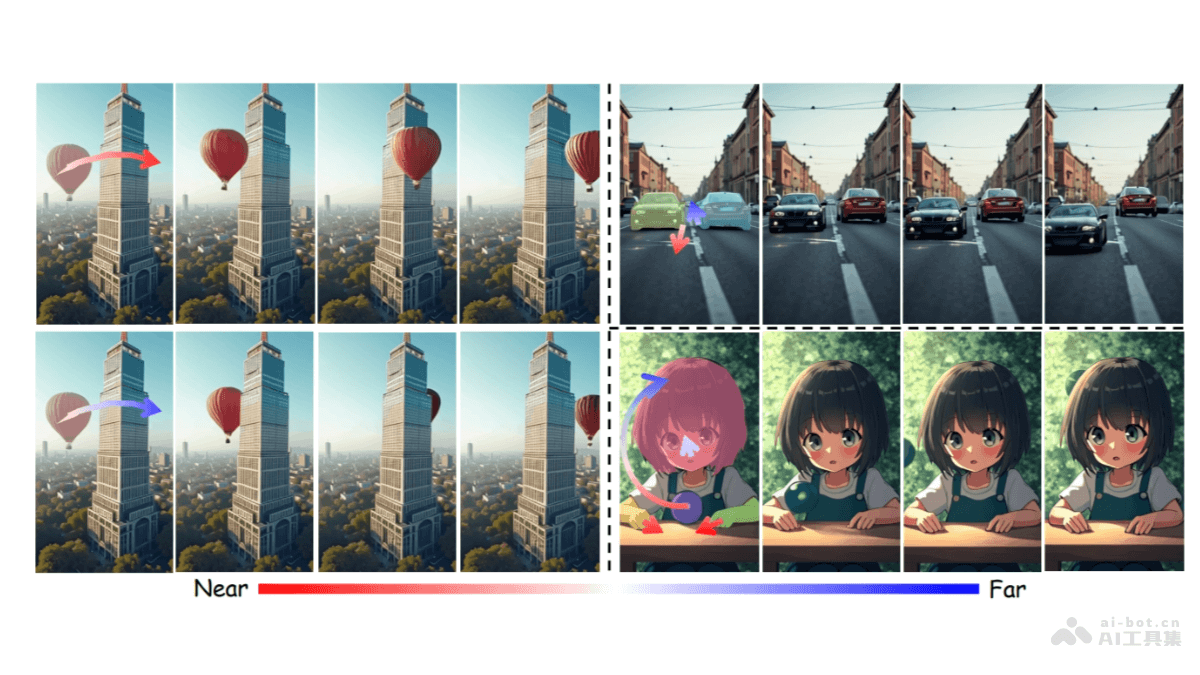

LeviTor – 南大联合蚂蚁等机构开源的3D目标轨迹控制视频合成技术

发表时间:2025-01-07

LeviTor是南京大学、蚂蚁集团、浙江大学等机构推出的图像到视频合成技术,结合深度信息和K-means聚类点控制视频中3D物体的轨迹,无需显式的3D轨迹跟踪。LeviTor用高质量的视频对象分割数据集进行训练,有效捕捉复杂场景中的物体运动和交互,基于用户友好的推理流程简化3D轨迹输入,让视频生成技术更加先进和易用。

【全文阅读】

-

3D-Speaker – 阿里通义推出的多模态说话人识别任务开源项目

发表时间:2025-01-07

3D-Speaker是阿里巴巴通义实验室语音团队推出的多模态开源项目,基于结合声学、语义、视觉信息,实现高精度的说话人识别和语种识别。3D-Speaker提供工业级模型、训练和推理代码,及大规模多设备、多距离、多方言的数据集,支持高挑战性的语音研究。

【全文阅读】

-

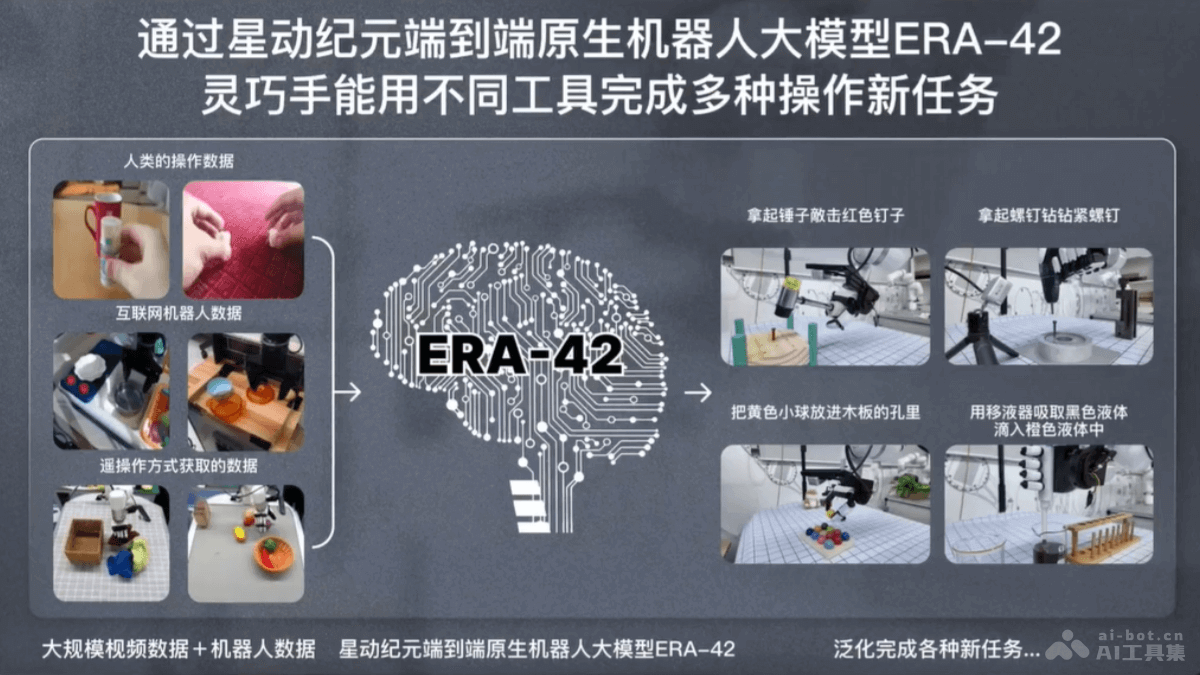

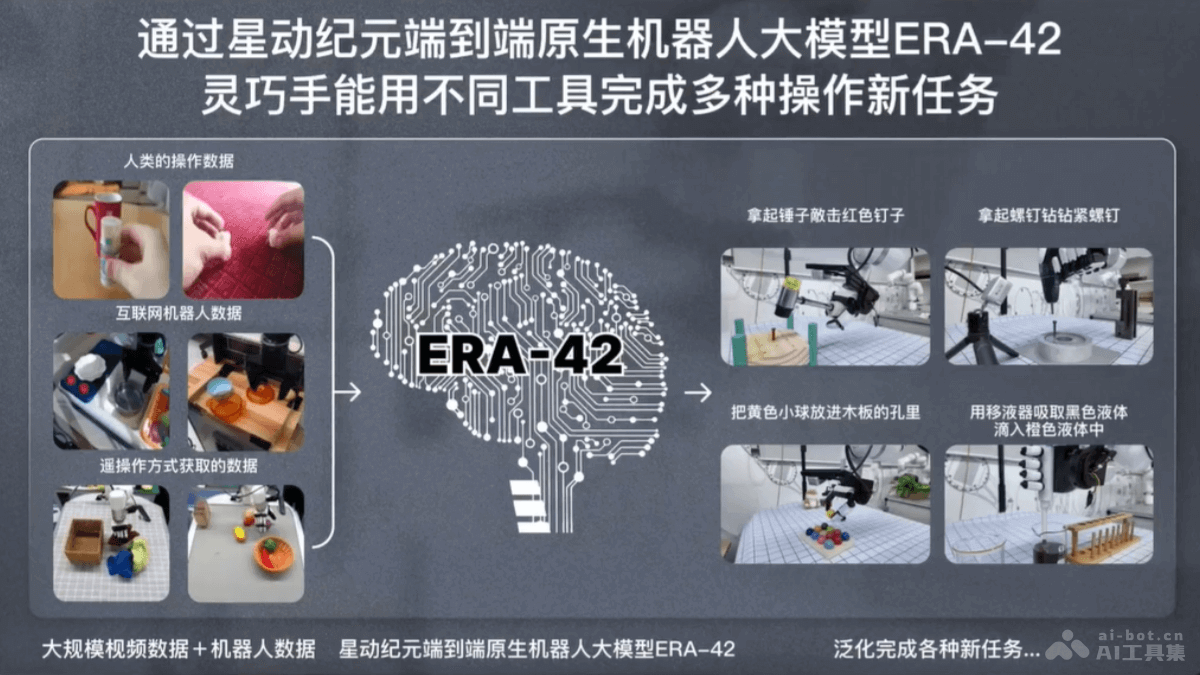

ERA-42 – 星动纪元推出的端到端原生机器人大模型

发表时间:2025-01-07

ERA-42是北京星动纪元推出的端到端原生机器人大模型,与自研的五指灵巧手星动XHAND1结合,能完成100多种复杂灵巧操作任务。ERA-42无需预编程,具备快速学习新技能的能力,能在2小时内用少量数据学会新任务。

【全文阅读】

-

Baichuan4-Finance – 百川智能推出的全链路金融领域增强大模型

发表时间:2025-01-07

Baichuan4-Finance是百川智能推出的全链路金融领域增强大模型,包括Baichuan4-Finance-Base和Baichuan4-Finance。基于Baichuan4-Turbo,用领域自约束训练,在保持通用能力的同时,增强金融知识。

【全文阅读】

-

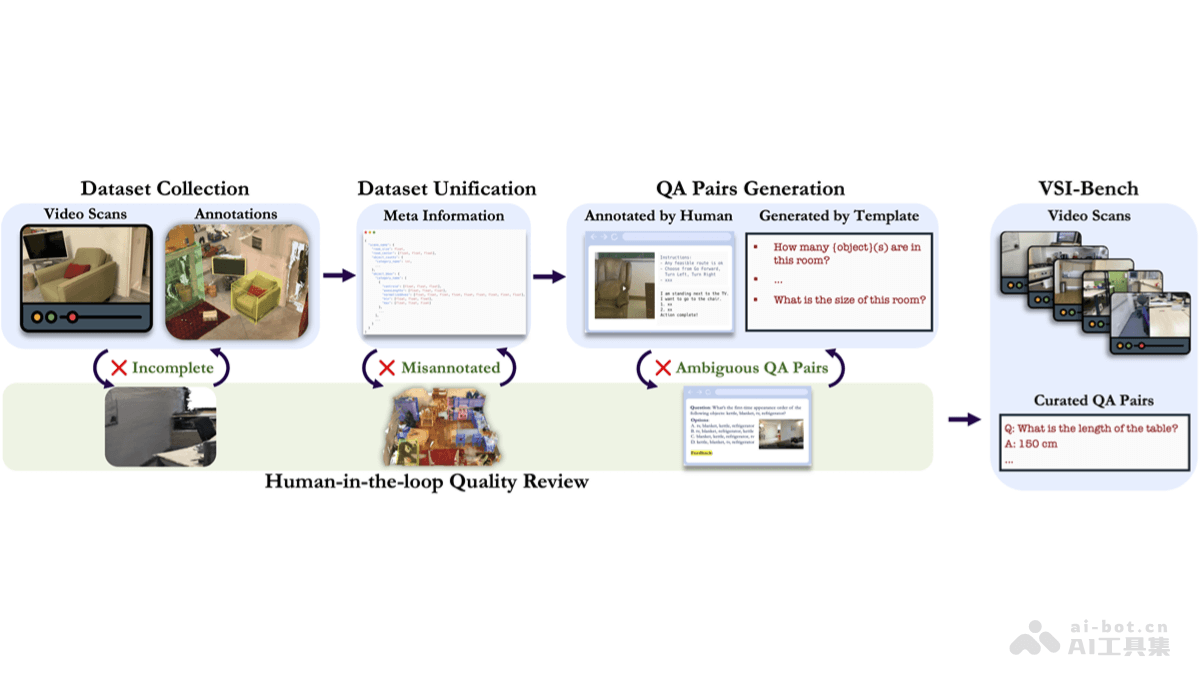

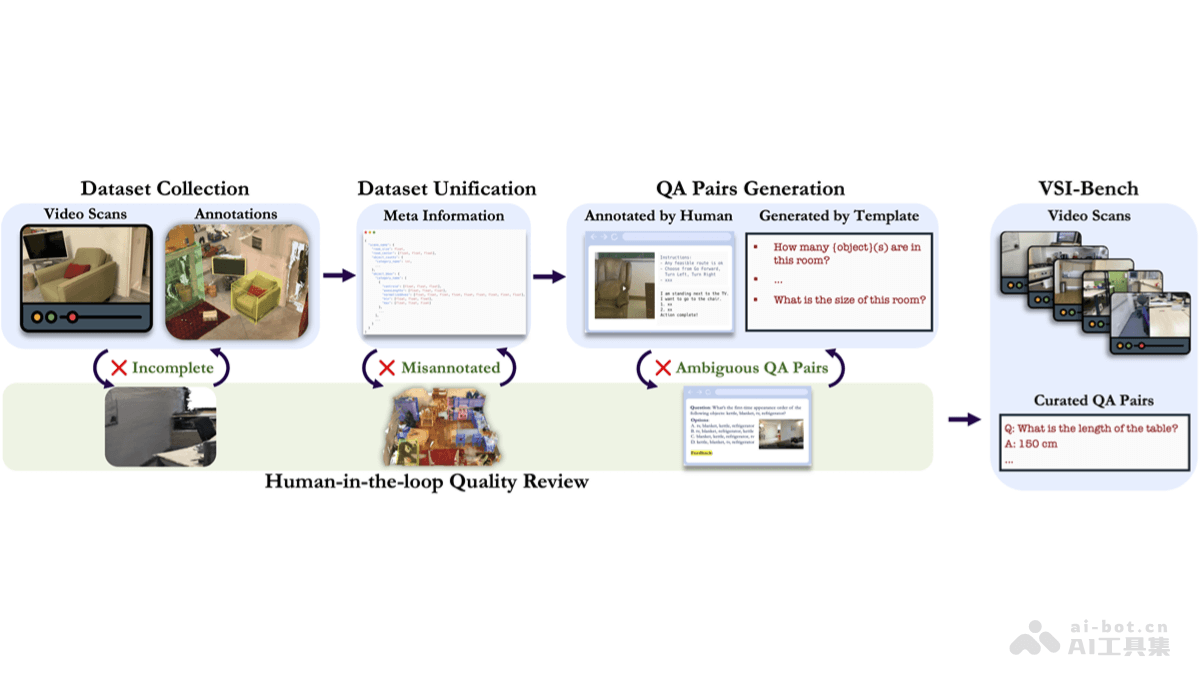

VSI-Bench – 李飞飞谢赛宁团队推出的视觉空间智能基准测试集

发表时间:2025-01-07

VSI-Bench(Visual-Spatial Intelligence Benchmark)是李飞飞、谢赛宁及他们的研究团队推出的视觉空间智能基准测试集,研究者构建用在评估多模态大型语言模型(MLLMs)在空间认知和理解方面的能力。VSI-Bench包含超过5000个问题-答案对,覆盖近290个真实室内场景视频,涉及住宅、办公室和工厂等多种环境。

【全文阅读】

-

Bamba-9B – 基于 Mamba2 架构的仅解码语言模型

发表时间:2025-01-07

Bamba-9B是IBM、普林斯顿大学、卡内基梅隆大学和伊利诺伊大学香槟分校联合推出的,基于Mamba2架构的仅解码语言模型模型。模型在完全开放的数据集上训练,能提高大型语言模型的推理效率,特别是在处理长文本时的内存带宽瓶颈。

【全文阅读】

-

Univer – 开源 AI 办公工具,支持Word、Excel等文档处理全栈解决方案

发表时间:2025-01-07

Univer是开源的全栈框架,支持创建和编辑电子表格、文档及幻灯片,为用户提供统一且强大的办公解决方案。Univer能在浏览器和Node js环境中运行,易于集成到各种应用中。Univer跨平台兼容性、强大的功能(包括公式计算、条件格式、数据验证等)、高度可扩展和可定制化的特点,及优异的性能表现,为用户提供现代化的办公工具。

【全文阅读】

-

Kheish – 开源的多智能体协调平台,可灵活配置多个Agent解决复杂任务

发表时间:2025-01-07

Kheish是开源的、基于大型语言模型(LLM)的多智能体编排平台,用多个专门的角色(智能体)和灵活的工作流协调复杂任务的各个步骤,如提案生成、审核、验证和格式化,产生高质量结果。平台能无缝集成外部模块,例如文件系统访问、shell命令和向量存储,丰富上下文并处理大型代码库或文档。

【全文阅读】

-

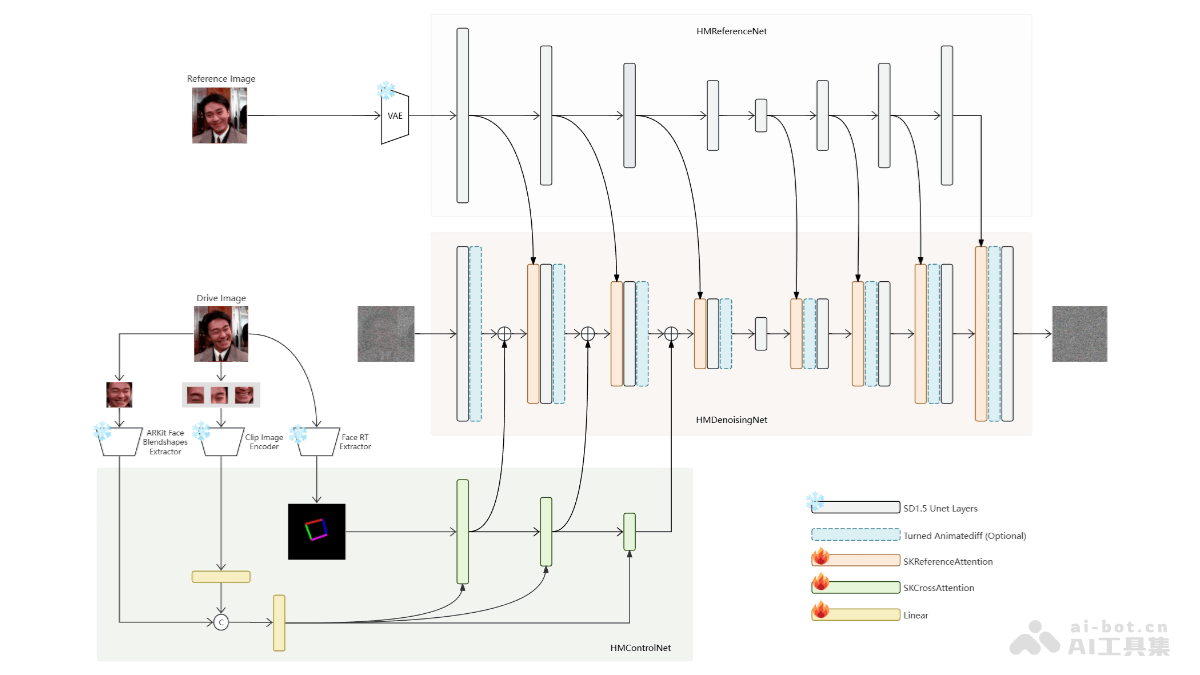

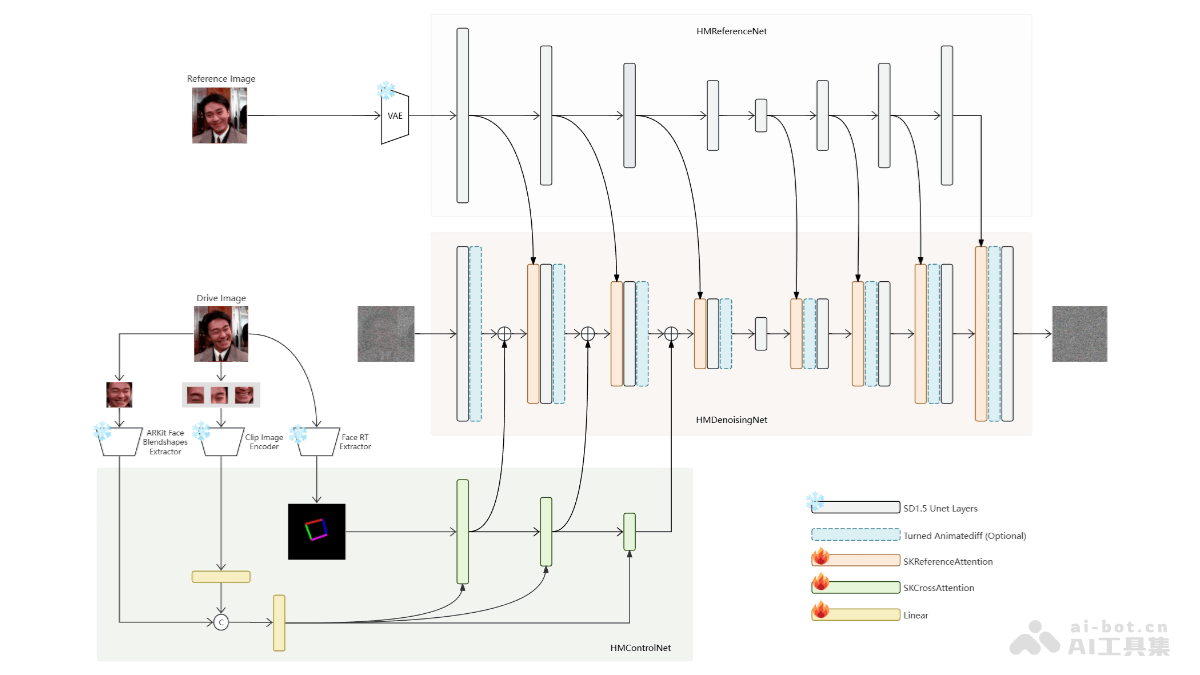

HelloMeme – 面部表情与姿态迁移框架,基于Stable Diffusion 1.5模型理解能力

发表时间:2025-01-07

HelloMeme是基于最新的Diffusion生成技术的框架,实现表情与姿态的迁移,HelloMeme集成空间编织注意力(Spatial Knitting Attentions)机制,基于Stable Diffusion 1 5模型的理解能力,将头部姿态和面部表情信息融合到去噪网络中,生成自然和物理合理的表情包视频。

【全文阅读】

-

InvSR – 开源图像超分辨率模型,高清修复老旧照片

发表时间:2025-01-07

InvSR是创新的图像超分辨率模型,基于扩散模型的逆过程恢复高分辨率图像。用大型预训练扩散模型中丰富的图像先验,改善超分辨率的效果。InvSR的核心在于深度噪声预测器,预测器能估计出在正向扩散过程中所需的最优噪声图。

【全文阅读】

-

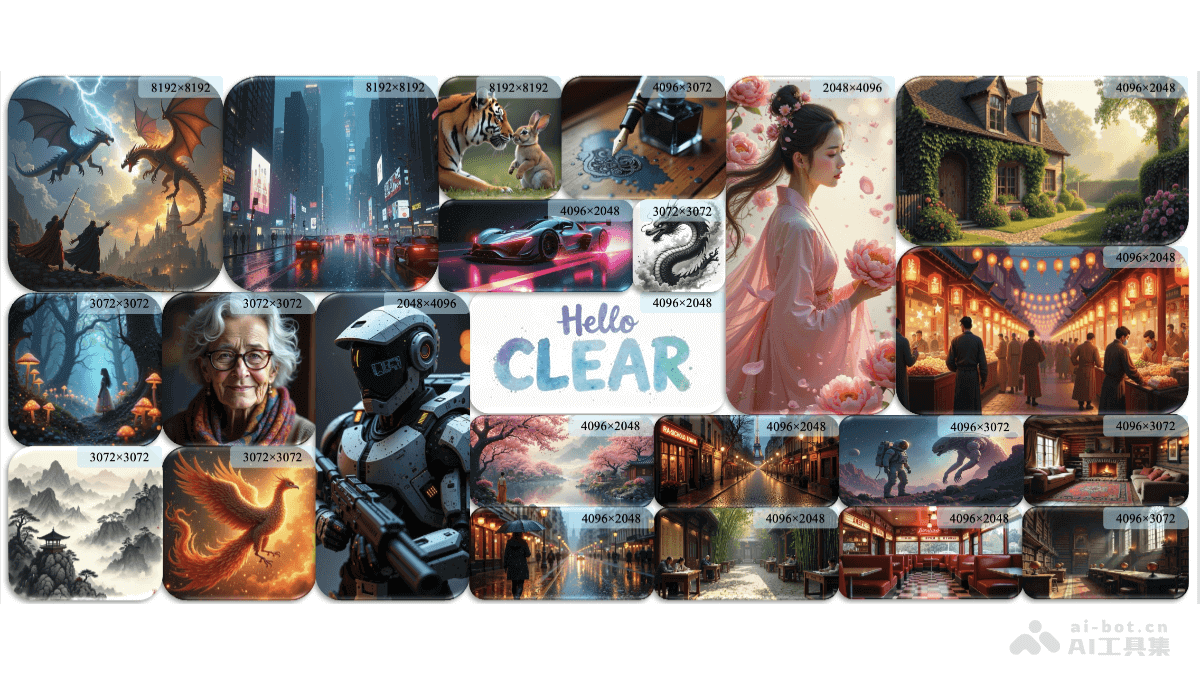

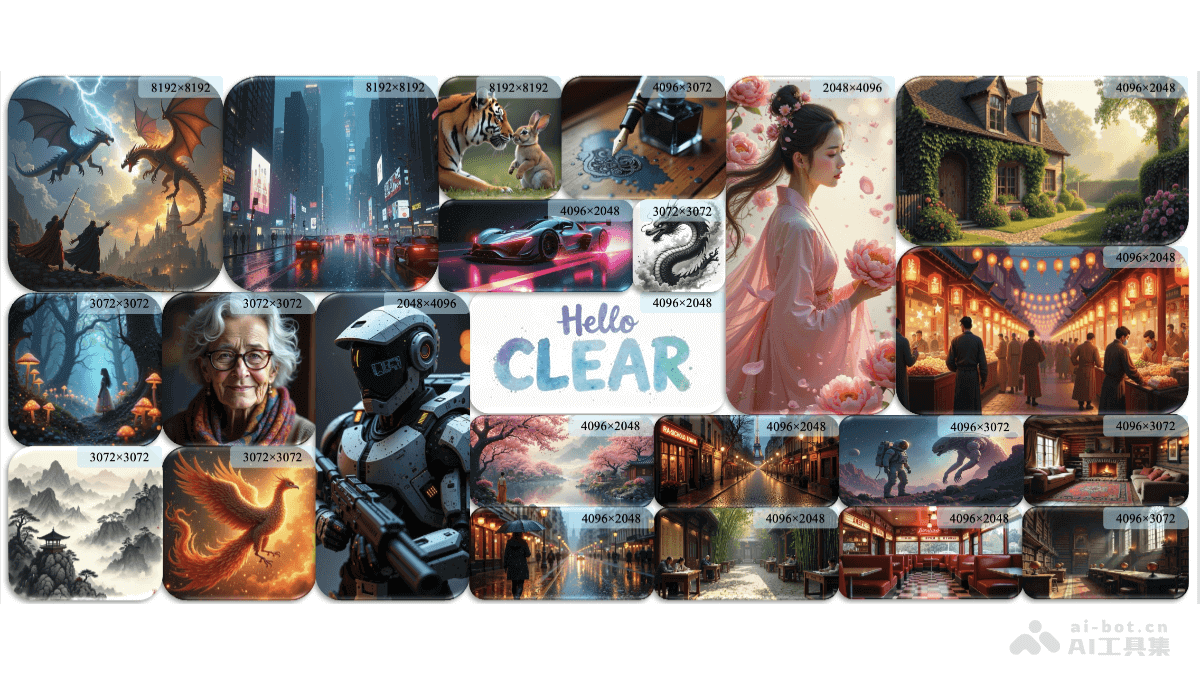

CLEAR – 新加坡国立大学推出的线性注意力机制,生成8K图像时提速6.3倍

发表时间:2025-01-07

CLEAR是新加坡国立大学推出新型线性注意力机制,能提升预训练扩散变换器(DiTs)生成高分辨率图像的效率。基于将每个查询的注意力限制在局部窗口内,CLEAR实现了对图像分辨率的线性复杂度,降低了计算成本。

【全文阅读】

-

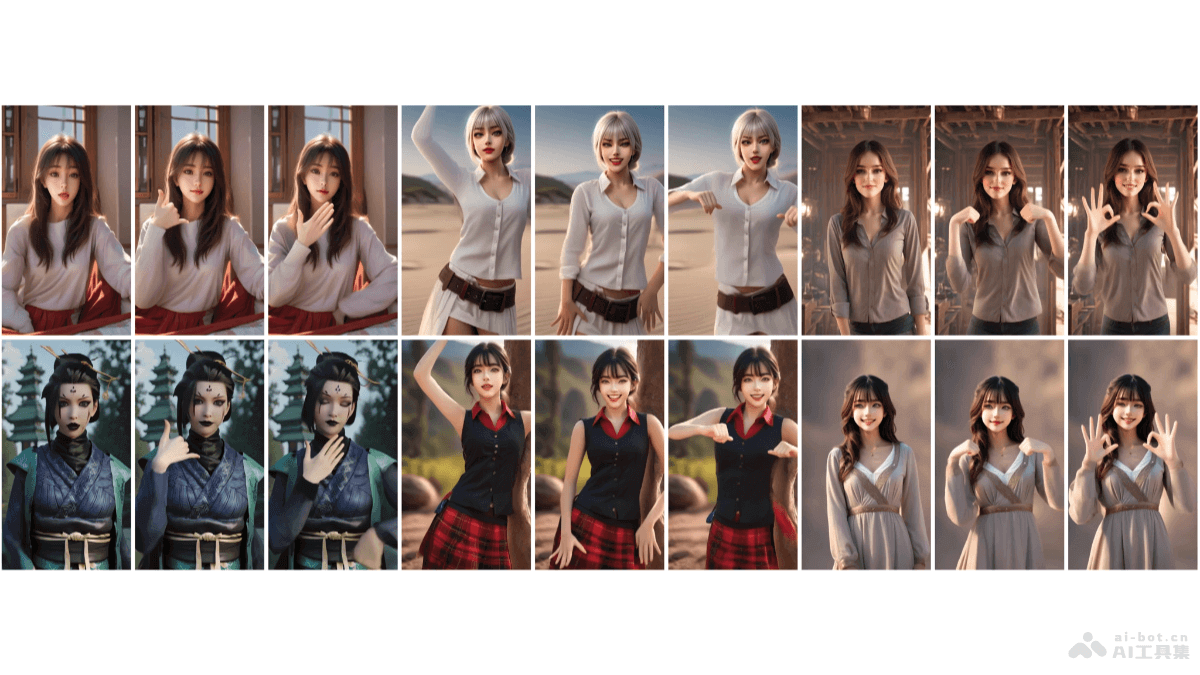

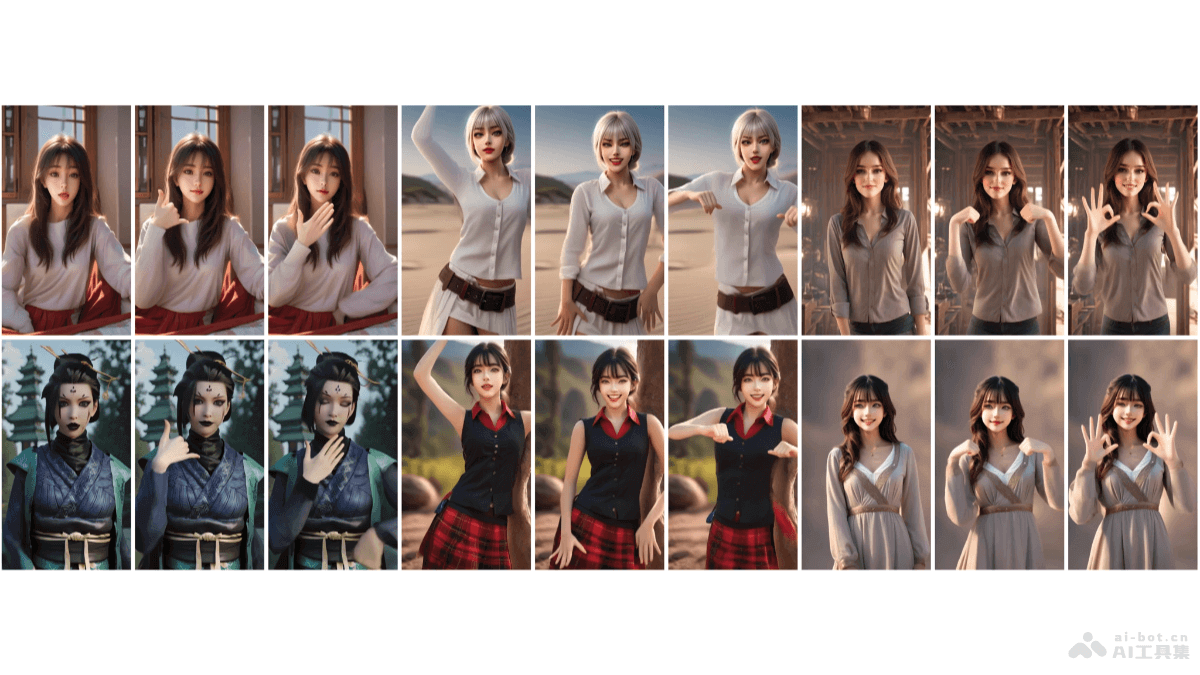

DisPose – 北大等多所高校推出的增强人物图像控制动画质量的技术

发表时间:2025-01-07

DisPose是北京大学、中国科学技术大学、清华大学和香港科技大学的研究团队共同推出的,提高人物图像动画质量的控制技术,基于从骨骼姿态和参考图像中提取有效的控制信号,无需额外的密集输入。DisPose将姿态控制分解为运动场引导和关键点对应,生成密集运动场以提供区域级引导,同时保持对不同体型的泛化能力。

【全文阅读】

-

OCTAVE – Hume AI推出的语音语言模型

发表时间:2025-01-07

OCTAVE(Omni-Capable Text and Voice Engine)是Hume AI推出的新一代语音语言模型,结合EVI 2模型和OpenAI、Elevenlab、Google Deepmind等系统的能力。OCTAVE能从简短提示或录音中生成个性化的声音和特质,包括语言、口音、情感等特征,支持实时互动和多角色对话。

【全文阅读】

-

Granite 3.1 – IBM 推出的新版语言模型

发表时间:2025-01-07

Granite 3 1是IBM推出的新一代语言模型,具有强大的性能和更长的上下文处理能力。Granite 3 1模型家族有 4 种不同的尺寸和 2 种架构:密集模型2B和8B参数模型,总共使用 12 万亿个token进行训练。专家混合MoE模型:稀疏1B和3B MoE 模型,分别具有 400M 和 800M 激活参数,总共使用 10 万亿个token进行训练。

【全文阅读】

-

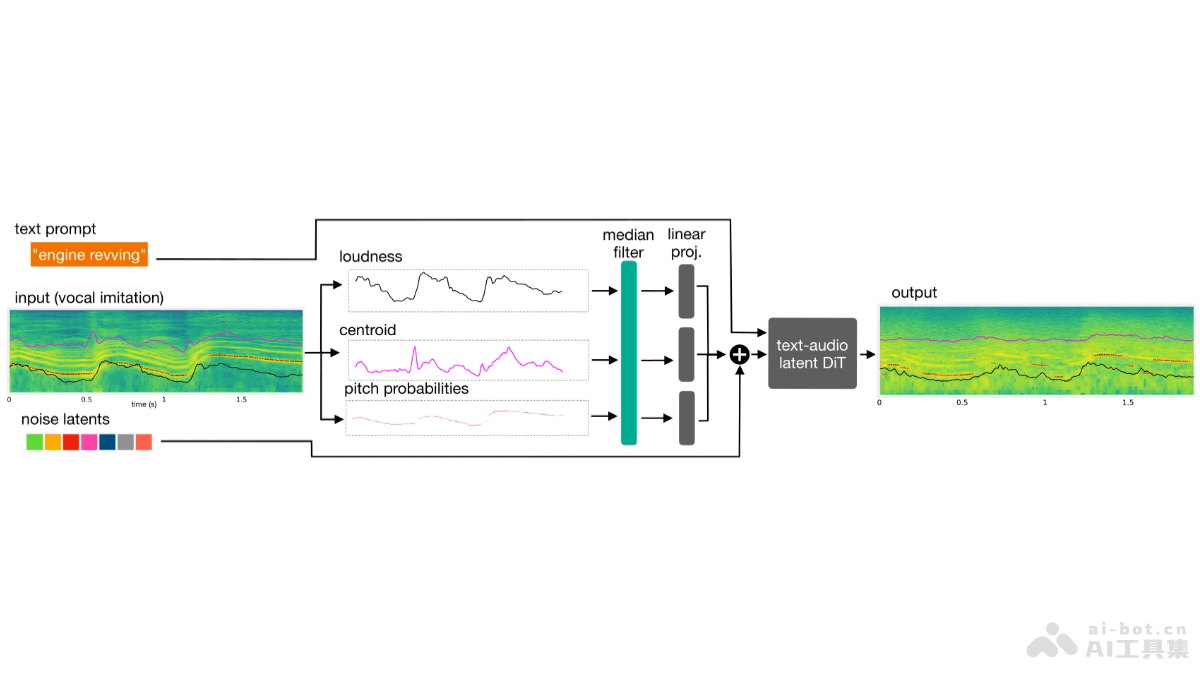

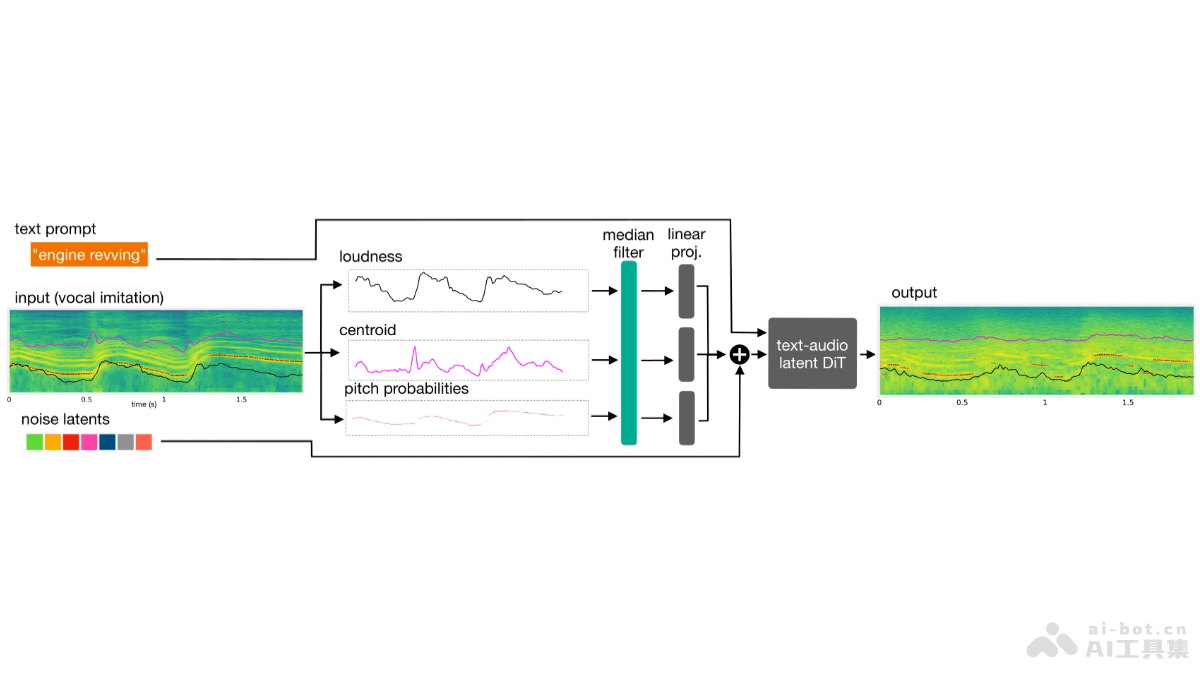

Sketch2Sound – Adobe 联合西北大学推出的AI音频生成技术

发表时间:2025-01-07

Sketch2Sound是Adobe 研究院和西北大学推出的AI音频生成技术,能基于声音模仿和文本提示生成高品质音效。Sketch2Sound从声音模仿中提取响度、亮度和音高三个控制信号,将控制信号编码后用于条件文本到声音的生成系统。

【全文阅读】

-

OmniAudio-2.6B – Nexa AI推出的端侧多模态音频语言模型

发表时间:2025-01-07

OmniAudio-2 6B是Nexa AI推出的音频语言模型,专为边缘部署设计,能实现快速且高效的音频文本处理。OmniAudio-2 6B是具有2 6亿参数的多模态模型融合Gemma-2-2b、Whisper Turbo和定制的投影模块,优化自动语音识别和语言模型的集成,减少延迟和资源消耗。

【全文阅读】

-

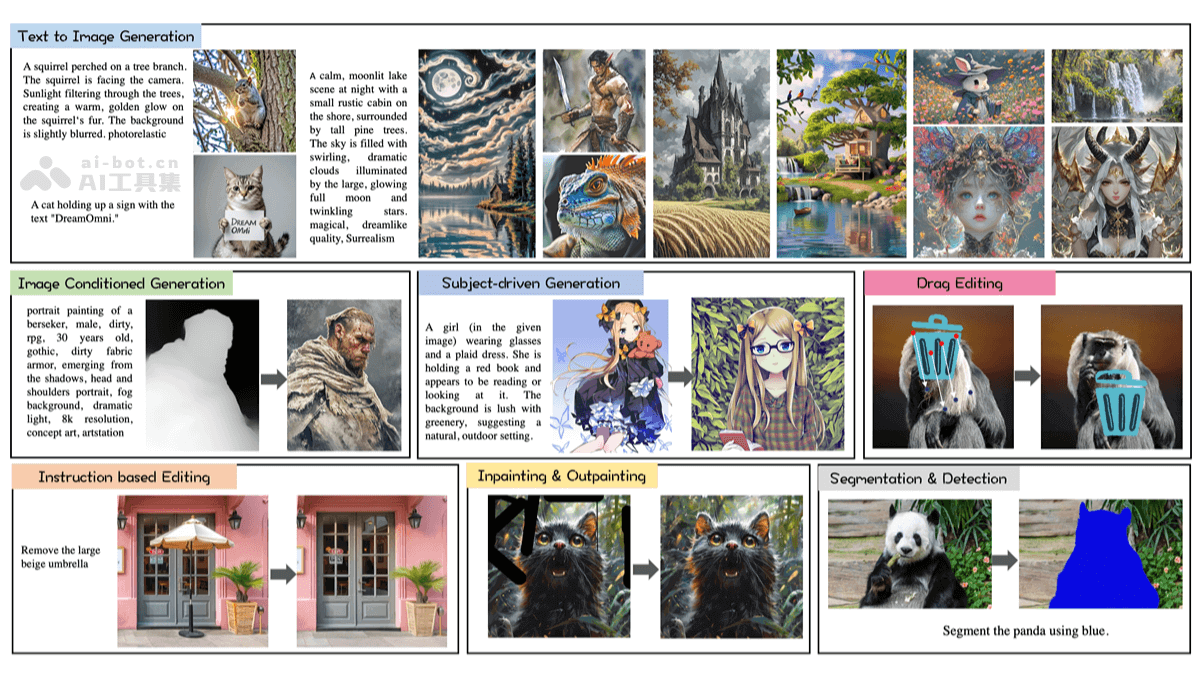

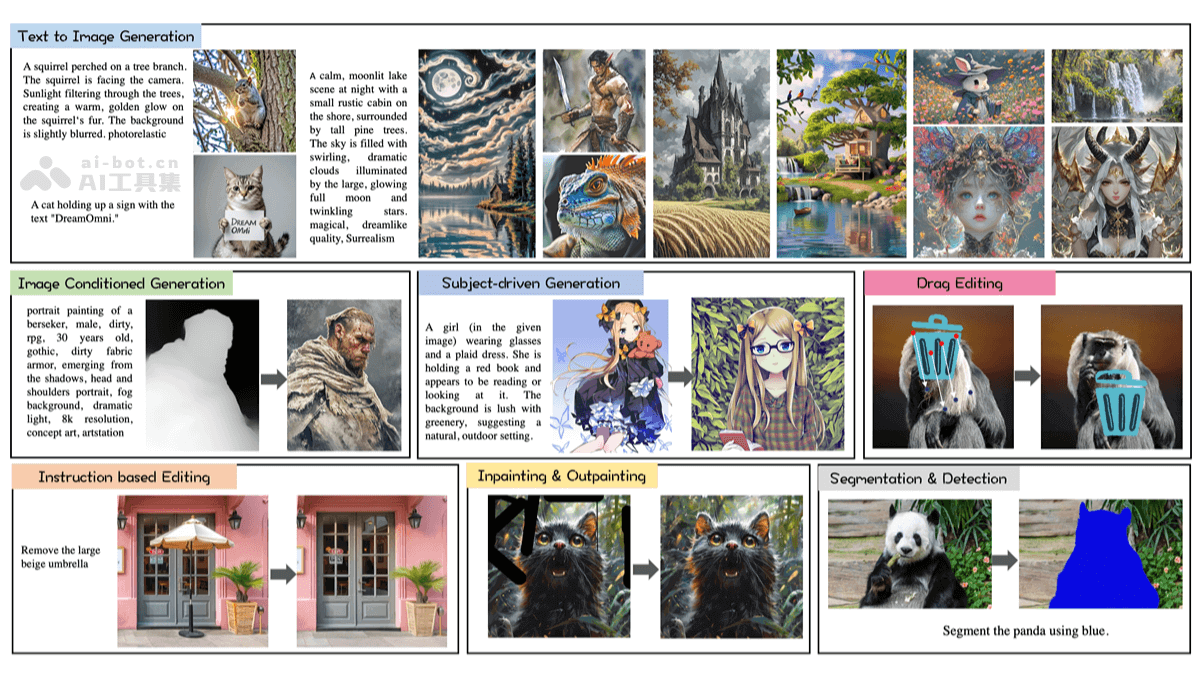

DreamOmni – 港中文、字节等机构共同推出的统一图像生成和编辑模型

发表时间:2025-01-06

DreamOmni 是香港中文大学、字节跳动和香港科技大学共同推出的统一图像生成和编辑模型。模型整合文本到图像(T2I)生成和多种编辑任务,包括指令式编辑、修复、拖拽编辑和参考图像生成。DreamOmni 基于一个高效的合成数据管道解决高质量编辑数据的创建难题,支持模型训练和扩展。

【全文阅读】